I. 개요

1. 사용 Software

| 제품명 | 버전 | 아키텍쳐 | 배포 사이트 |

|---|---|---|---|

| VirtualBox | 6.1.x | 호스트 환경에 따름 | https://www.virtualbox.org |

| Oracle Enterprise Linux | 7 (Update 5 이상 권장) | x86 64bit | |

| Oracle 11g RAC | 11.2.0.4 | Linux x86 64bit | https://edelivery.oracle.com (등록된 고객만 다운로드 가능) |

| Oracle 11g GI Patch | 18370031 | Linux x86 64bit | https://support.oracle.com (Extended Support 고객만 다운로드 가능) |

| Oracle 11g Patch Set Update | 30501155 (202001) | Linux x86 64bit | https://support.oracle.com (Extended Support 고객만 다운로드 가능) |

| Oracle 19c RAC | 19.3 | Linux x86 64bit | http://www.oracle.com/technetwork/database/enterprise-edition/downloads/index.html |

| Oracle 19c Release Update | 30501910 (202001) | Linux x86 64bit | https://support.oracle.com (등록된 고객만 다운로드 가능) |

| Opatch | 11.2 & 12.2 | Linux x86 64bit | https://support.oracle.com (등록된 고객만 다운로드 가능) |

- Linux 7에 GI 설치를 위해서 18370031 패치는 필수 입니다. 패치를 적용하지 않고 root 스크립트를 수행할 경우 클러스터 구성에 실패합니다.

- GI를 11.2.0.4에서 19c로 업그레이드 하려면 28553832 (11.2.0.4.GIPSU:191015), 17617807 (11.2.0.4.GIPSU04), 21255373 (11.2.0.4.GIPSU:160419) 패치가 필요합니다.

- PSU 패치 30501155 (11.2.0.4.GIPSU:200114)를 적용하면 3가지가 통합되어 패치가 됩니다.

2. 구성 계획

A) 서버

| VM | Host Name | Memory | Net Adapter 1 | Net Adapter 2 | 구성 방법 | 비고 |

|---|---|---|---|---|---|---|

| RAC1 | rac1 | 10GB | 브리지 어댑터 | 호스트 전용 어댑터 | 리눅스 설치 | dnsmasq를 사용하여 DNS 구성 |

| RAC2 | rac2 | 10GB | 브리지 어댑터 | 호스트 전용 어댑터 | RAC1 복제 | dnsmasq를 사용하여 DNS 구성 |

리눅스 기반의 2 node RAC로 구성합니다.

B) 스토리지

| 파일 이름 | 용량 | 타입 | 용도 | 비고 |

|---|---|---|---|---|

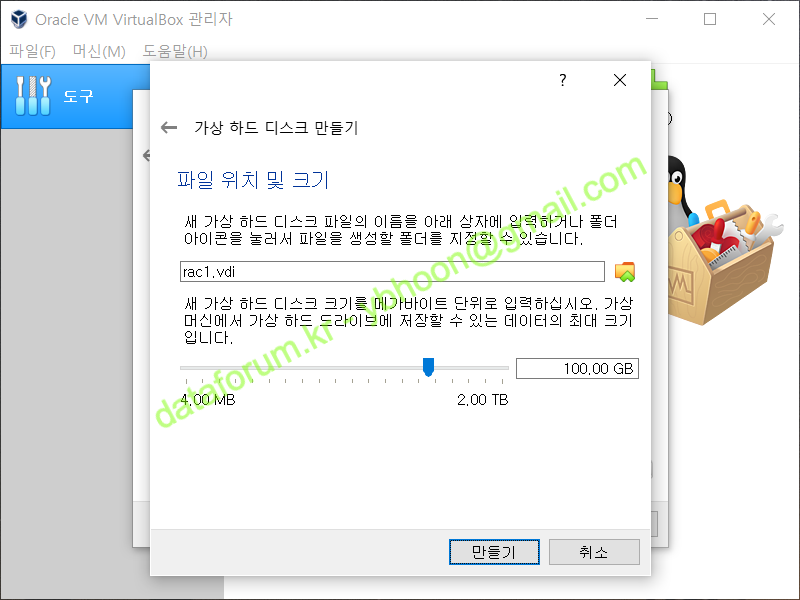

| rac1.vdi | 100GB | Dynamic / Normal | RAC1 노드 스토리지 | 디스크 사용량을 최소화하기 위해 Dynamic으로 생성합니다. |

| rac2.vdi | 100GB | Dynamic / Normal | RAC2 노드 스토리지 | vboxmanage clonemedium을 이용하여 rac1.vdi 파일을 복제합니다. |

| CRS1.vdi | 1GB | Fixed / Shareable | OCR / Vote 저장 영역 | 공유(shareable) 디스크로 사용하기 위해서는 Fixed Size로 생성해야 합니다. |

| CRS2.vdi | 1GB | Fixed / Shareable | ||

| CRS3.vdi | 1GB | Fixed / Shareable | ||

| DATA.vdi | 30GB | Fixed / Shareable | DATA 영역 | |

| FRA.vdi | 20GB | Fixed / Shareable | Fast Recovery Area |

Automatic Storage Management를 이용하여 Data 공간과 Fast Recovery Area를 구성합니다.

테스트를 위한 VM이므로 디스크 공간을 절약하기 위해 파일을 업로드 없이 VirtualBox의 게스트 확장 기능으로 VM에서 불러와 사용합니다.

C) 네트워크

| VM | Public IP | Private IP | Virtual IP | Netmask | Gateway | DNS Server | SCAN IP |

|---|---|---|---|---|---|---|---|

| RAC1 | 10.0.1.101 | 10.0.5.101 | 10.0.1.201 | 255.255.255.0 | 10.0.1.1 | 127.0.0.1 | 10.0.1.191, 10.0.1.192, 10.0.1.193 |

| RAC2 | 10.0.1.102 | 10.0.5.102 | 10.0.1.202 | 255.255.255.0 | 10.0.1.1 | 127.0.0.1 |

Netmask의 경우 Public과 Private 모두 24bit(255.255.255.0)을 사용합니다.

인터넷 공유기 또는 Gateway의 IP에 맞춰 Public IP와 Virtual IP를 설정하기 바랍니다.

별도의 DNS 서버 구성 없이 dnsmasq를 사용하여 RAC를 구축할 계획이므로 DNS는 Loopback IP로 지정합니다.

3. 호스트 환경

A) 시스템

12c부터는 64비트의 운영체제만을 지원하므로, 호스트 장비 또한 64비트 운영체제를 사용하여 구축해야 합니다.

메모리는 오라클의 권고에 따라 VM 노드당 8GB 이상이 필요하므로, 가능하면 20GB 이상의 메모리가 장착된 환경에서 작업하는 것을 권합니다.

(구축 테스트를 위해 임시적으로 설치하는 것이라면 경고 메시지를 무시하고 8GB 이하로 구성할 수도 있으나, 운영 환경에서는 권고하지 않습니다.)

B) 스토리지

디스크 I/O에 의한 지연을 최소화하기 위해 호스트의 OS가 설치되지 않은 별도의 내장 디스크를 사용하거나 SSD의 사용을 권합니다.

ESATA 또는 USB 3.0 이상의 빠른 속도를 보장하는 외장 디스크를 사용하는 것도 방법일 수 있습니다만 지속적인 연결이 보장되어야 합니다.

사실상 디스크의 속도에 따라 설치에 소요되는 시간이 크게 좌우되므로, 가급적이면 안정적이고 빠른 스토리지를 사용하기 바랍니다.

II. VM 구성

1. VM 생성

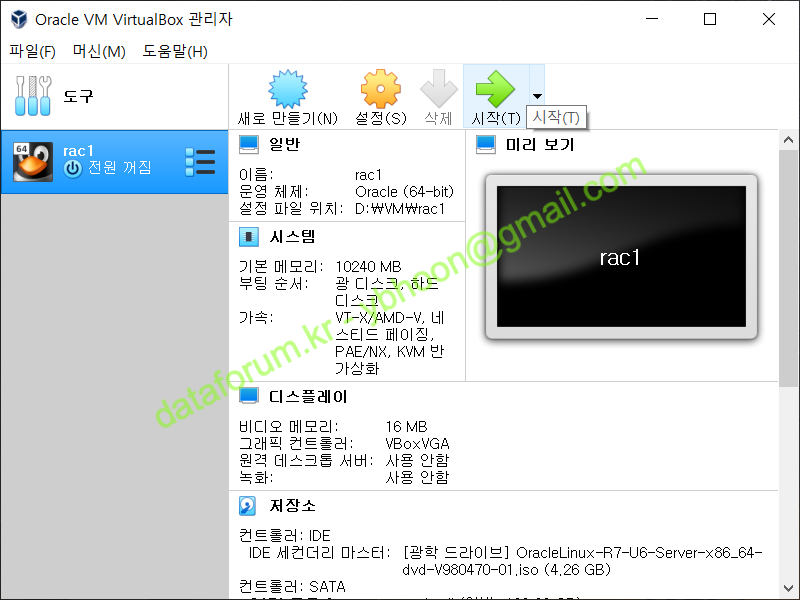

RAC 1번 노드 구성을 위한 VM을 생성합니다.

<새로 만들기> 버튼을 클릭합니다.

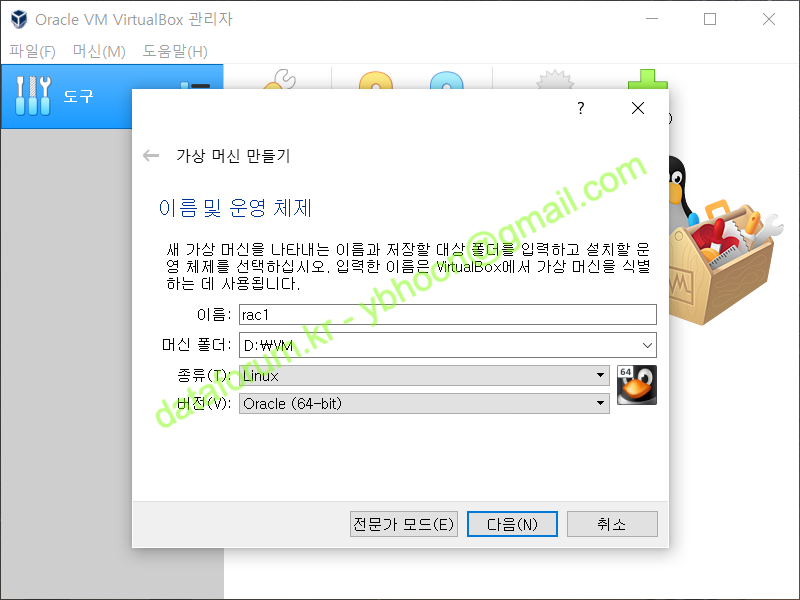

A) 가상 머신 만들기

OS의 종류는 'Linux'로 하고 설치될 버전은 'Oracle (64-bit)'를 선택합니다.

머신 폴더는 VM 설정을 위한 파일이나, 가상 이미지를 저장할 디렉토리를 선택합니다. 가급적 성능이 좋은 디스크나 SSD에 저장할 것을 권합니다.

Oracle Database은 12c R1 버전부터 64bit만을 지원하고 있습니다.

Client 소프트웨어만 32bit 프로그램을 제공합니다.

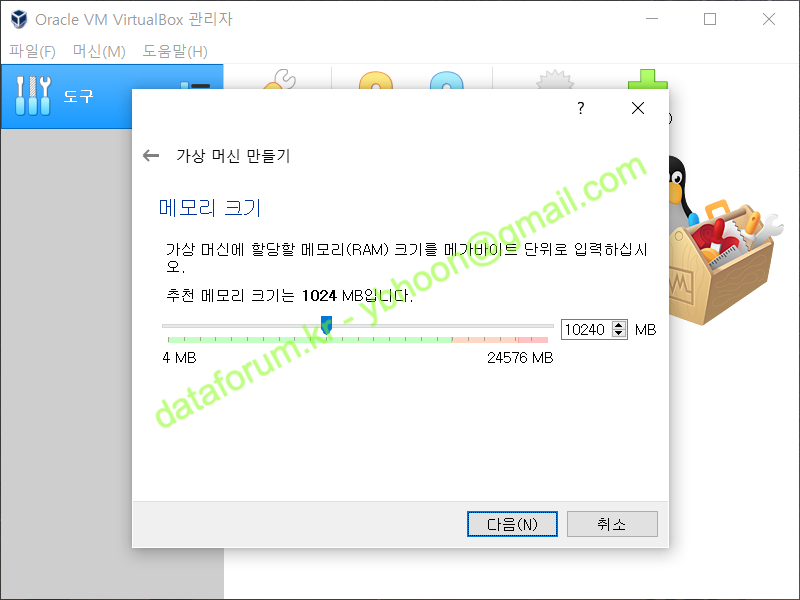

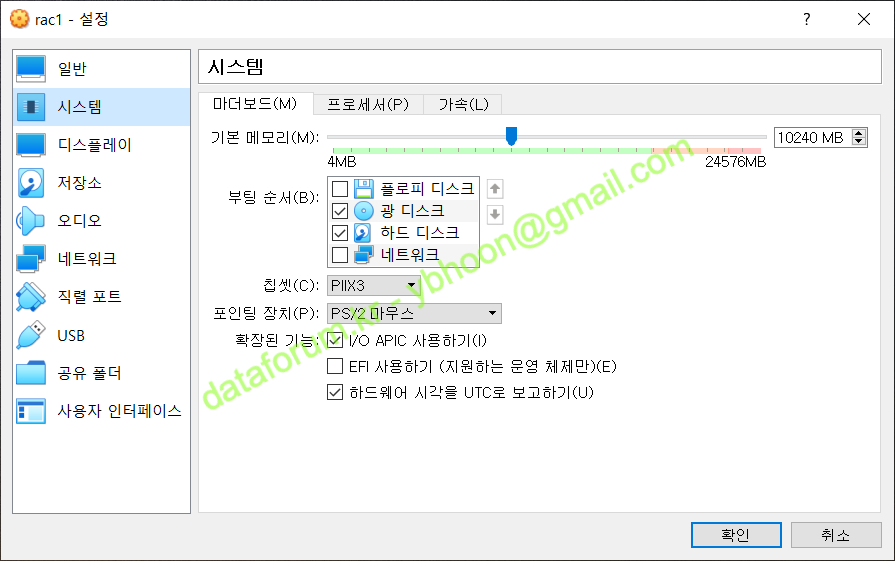

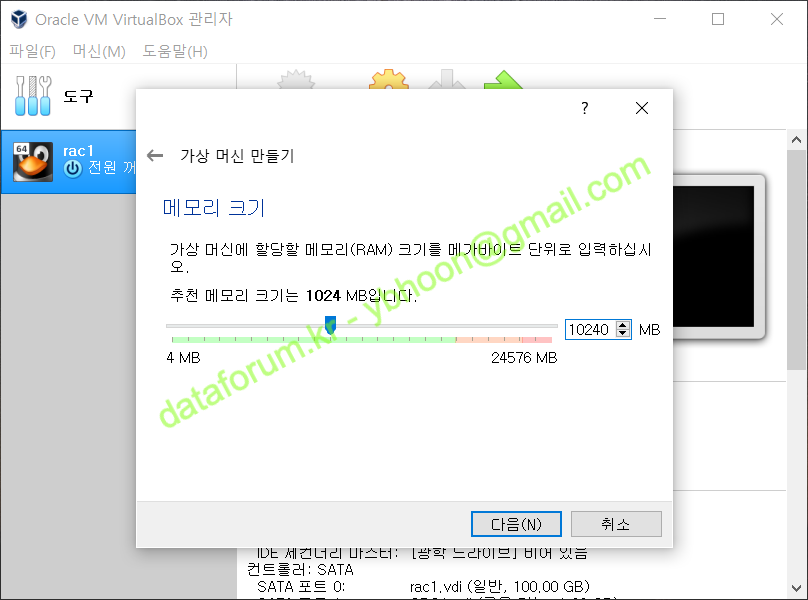

기본 메모리는 "10240MB"로 지정합니다.

Grid를 설치하기 위한 최소 메모리는 8GB 이지만, 원활한 작업을 위해서는 가급적 10GB 이상을 할당하는 것이 좋습니다.

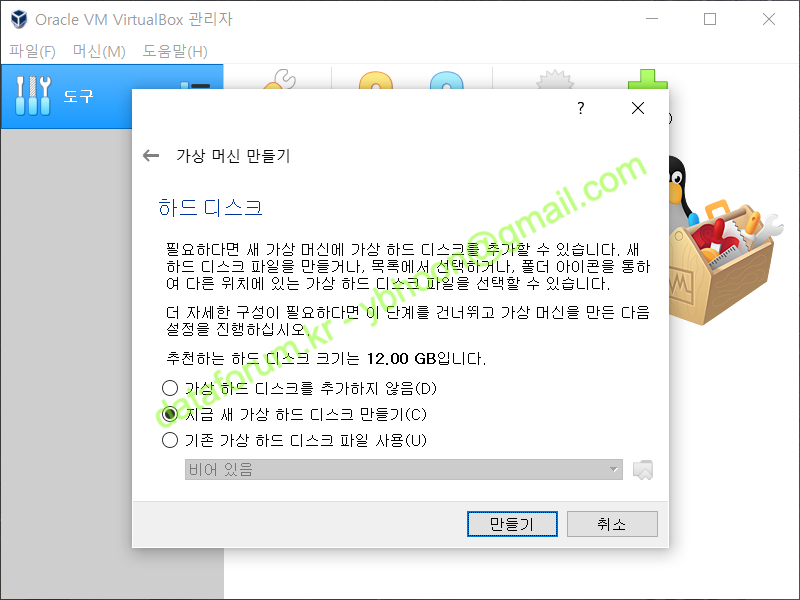

새로운 디스크를 생성해야 하므로 '지금 새 가상 하드 디스크 만들기'를 선택하고 <만들기>를 클릭합니다.

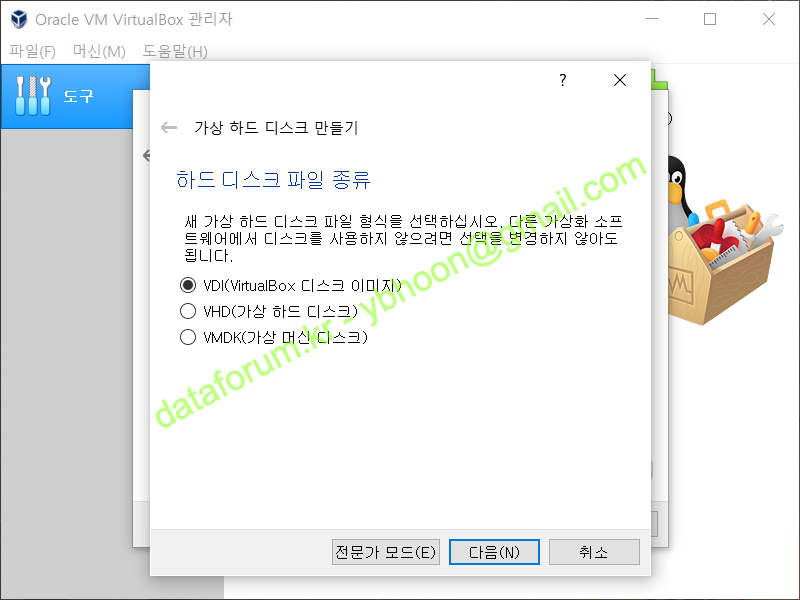

B) 가상 하드 디스크 만들기

가상 하드 디스크 파일의 종류는 'VDI(VirtualBox 디스크 이미지)'를 선택한 후 <다음>을 클릭합니다.

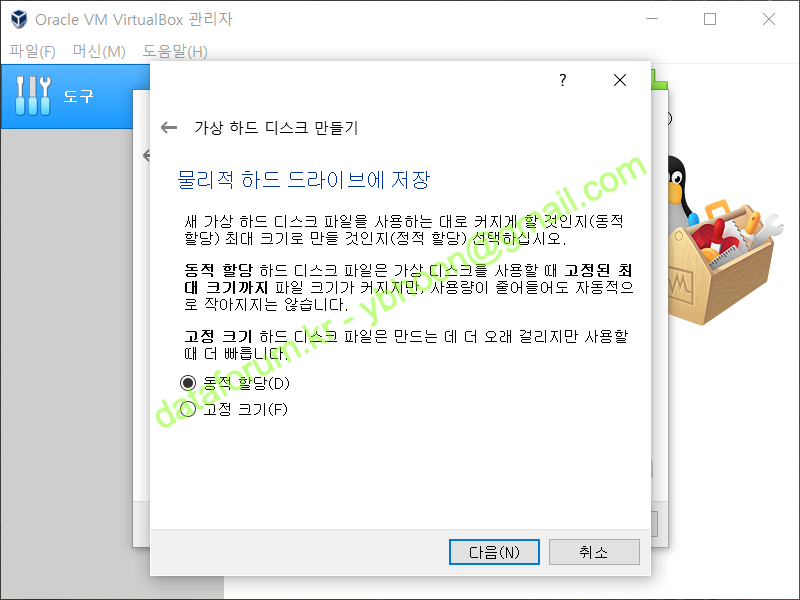

물리적 하드 드라이브 저장 방식은 '동적 할당'으로 하고 <다음>을 클릭합니다.

디스크 파일의 크기는 "100GB"로 한 후 <만들기>를 클릭하면 VM이 생성됩니다.

2. VM 설정 변경

생성된 가상 머신의 설정을 변경해야 하므로, 가상 머신을 선택하고 <설정>을 클릭합니다.

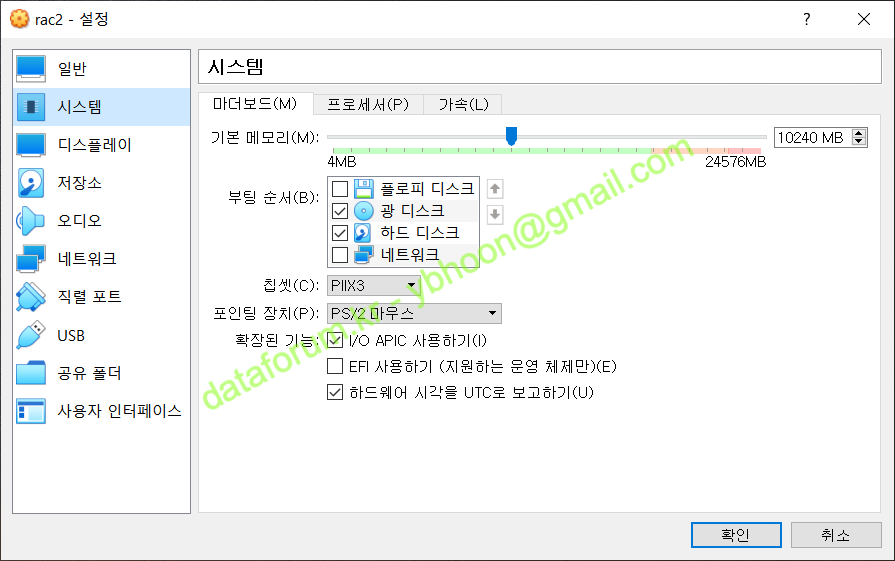

A) 시스템

부팅 순서에서 "플로피 디스크"를 해제하고, "광 디스크"가 우선권을 갖도록 합니다.

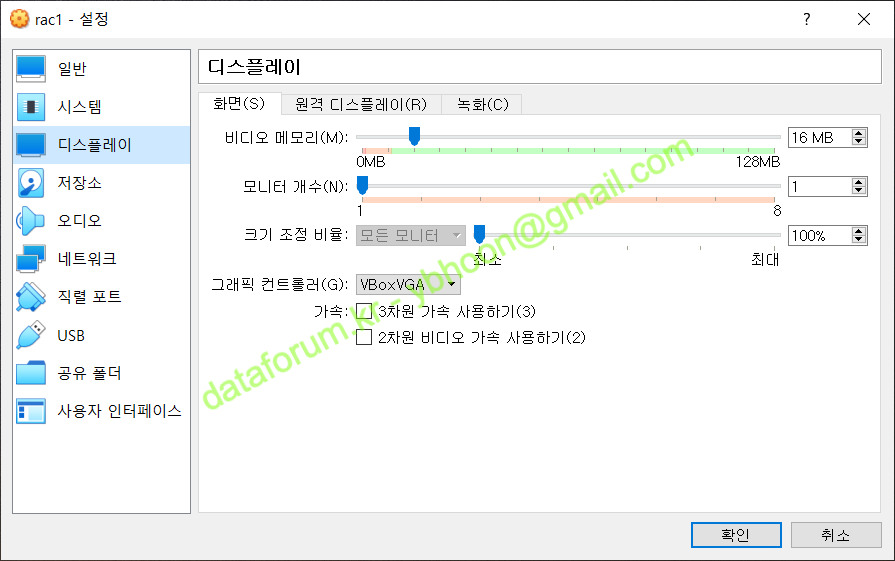

B) 디스플레이

VirtualBox에서 제공하는 Guest Additions 기능을 설치하는 과정에서 화면이 깨지는 경우가 있으므로, 잠시 그래피 컨트롤러를 "VBoxVGA"로 선택합니다.

설치가 정상으로 된 후에는 원래의 설정인 "VMSVGA"로 원복시켜주면 됩니다.

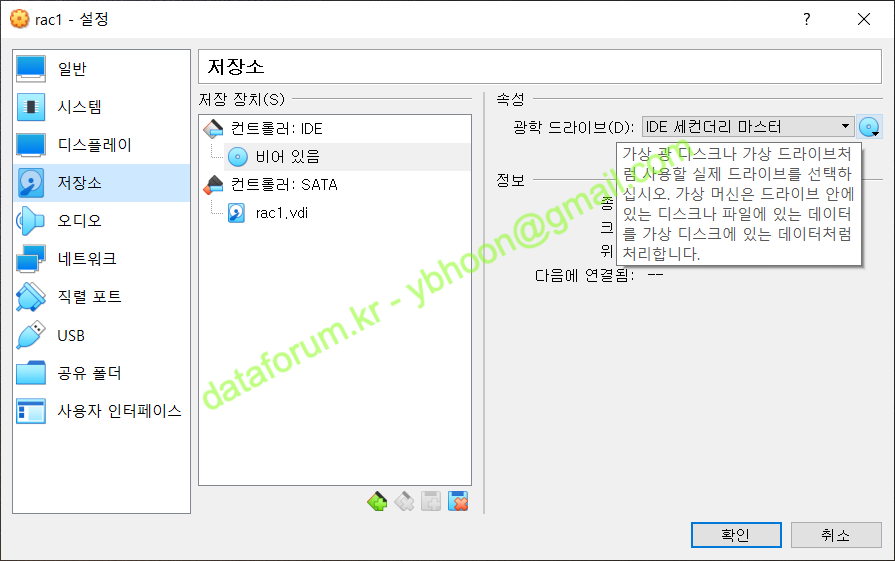

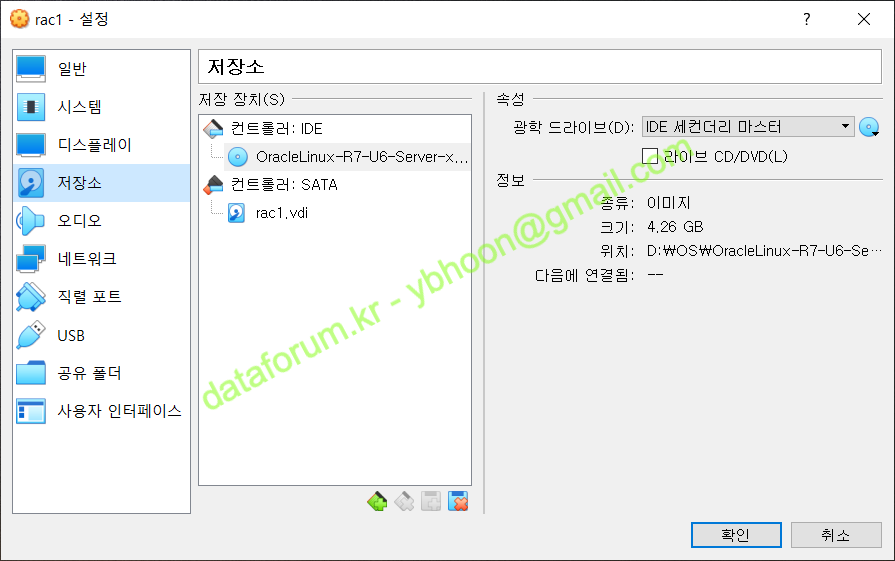

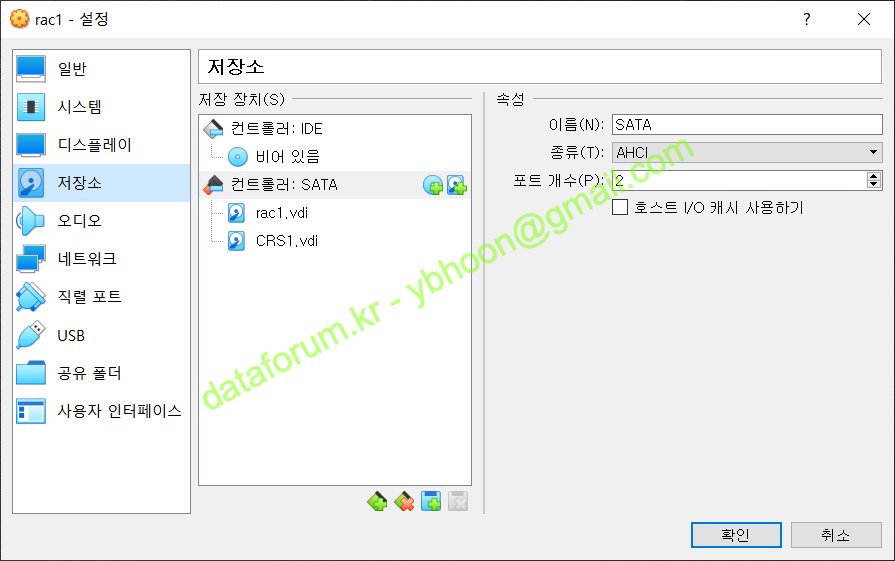

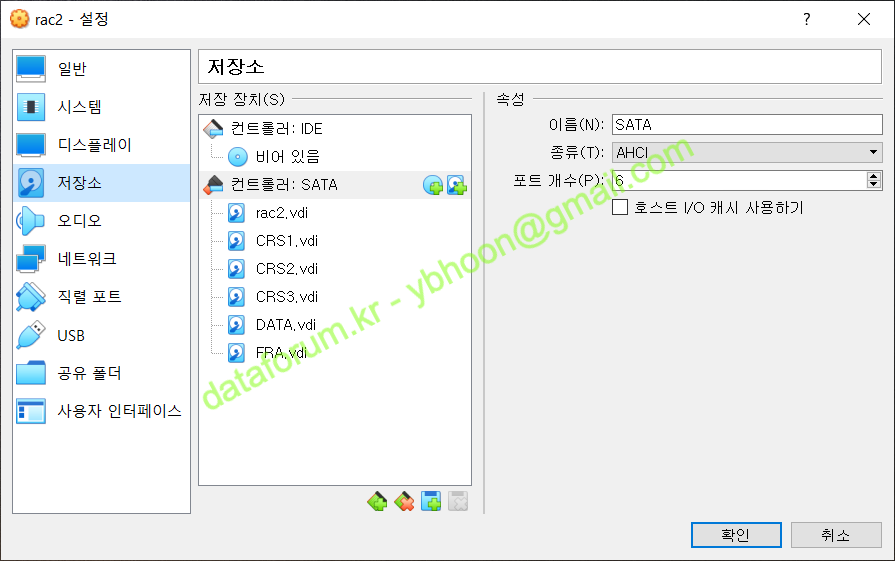

C) 저장소

설치할 리눅스 디스크 이미지를 마운트 하기 위해 저장소로 이동합니다.

'컨트롤러 : IDE'를 선택하고, 속성의 '광학 드라이브' 우측의 광 디스크 모양 아이콘을 클릭합니다.

리눅스 이미지가 있는 경로를 찾아가서 마운트하면, IDE 컨트롤러에 리눅스 설치 이미지가 마운트 됩니다.

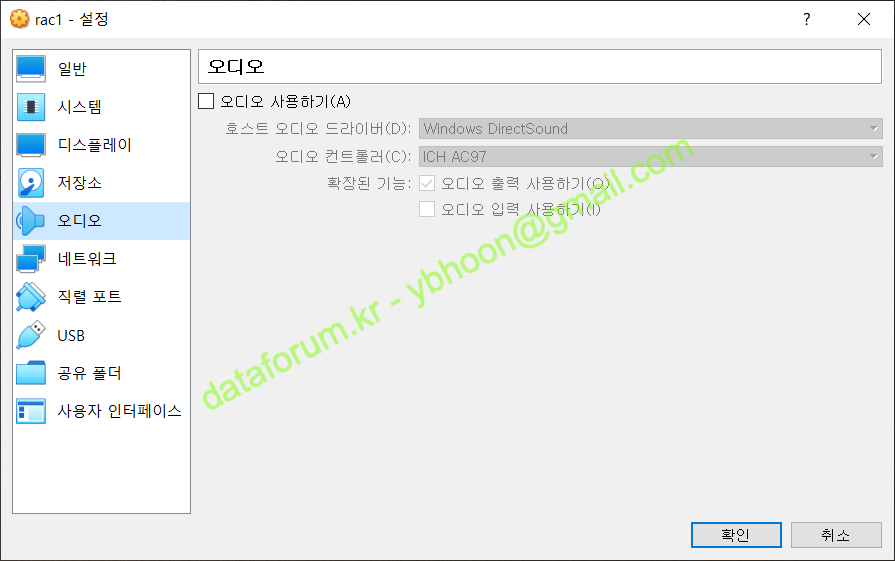

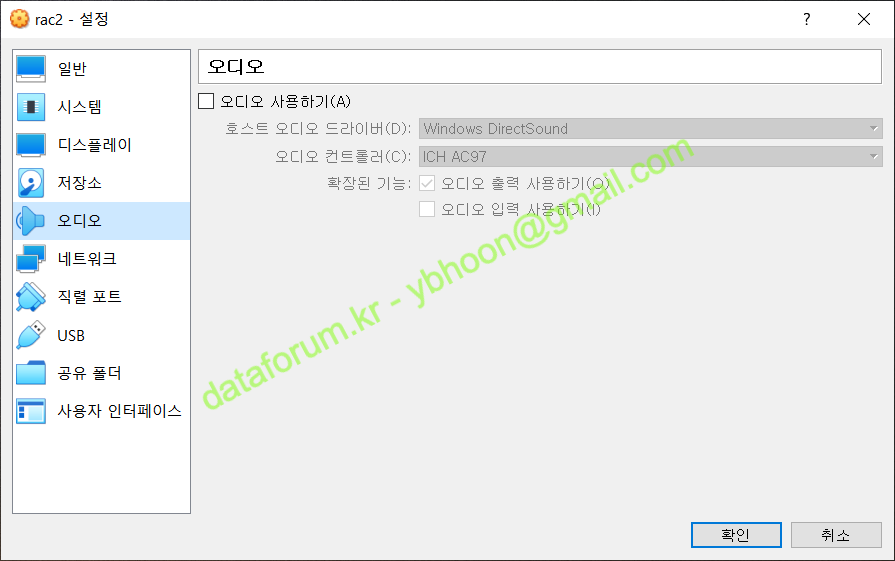

D) 오디오

오디오는 사용하지 않을 것이므로 '오디오 사용하기'는 해제합니다.

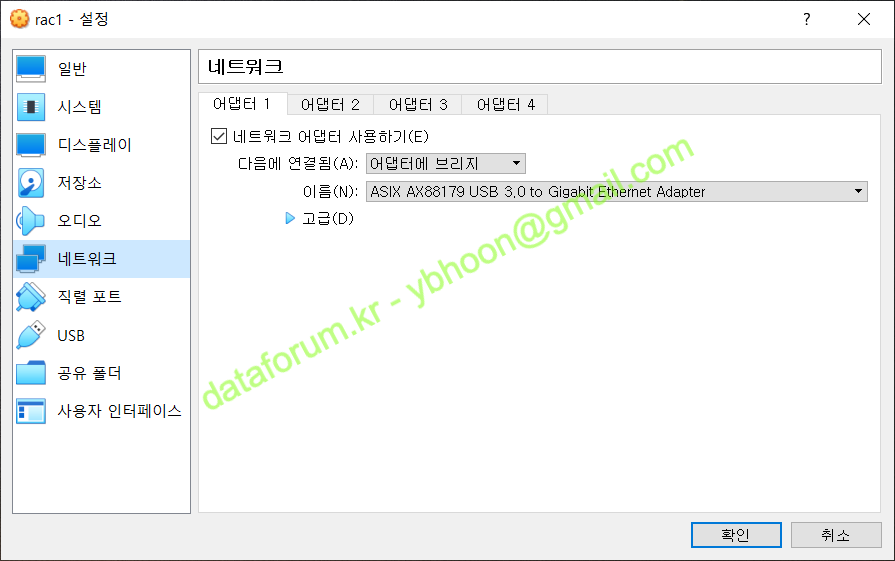

E) 네트워크

1번 네트워크 카드를 설치될 환경에 맞게 적절한 장치에 연결합니다.

일반적으로 외부와 통신을 하기 위해서 '어댑터에 브리지'를 선택합니다.

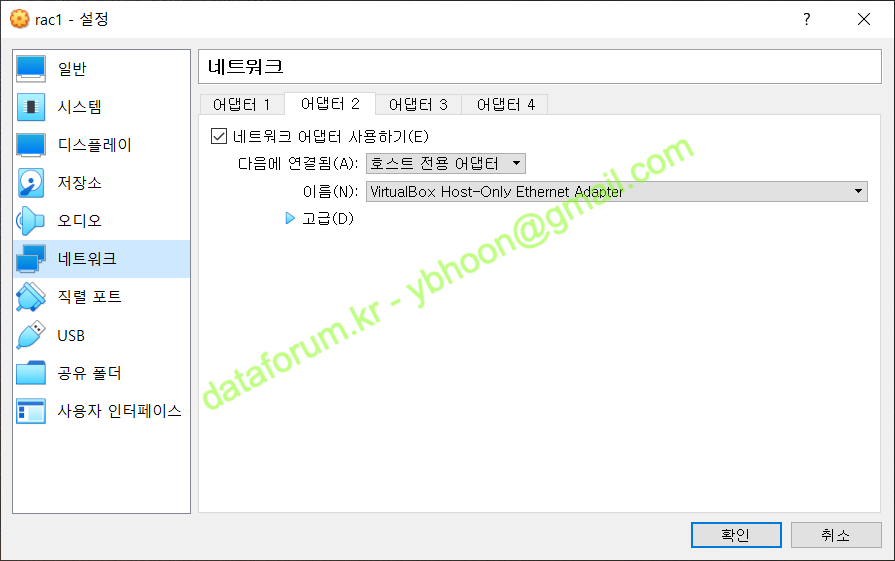

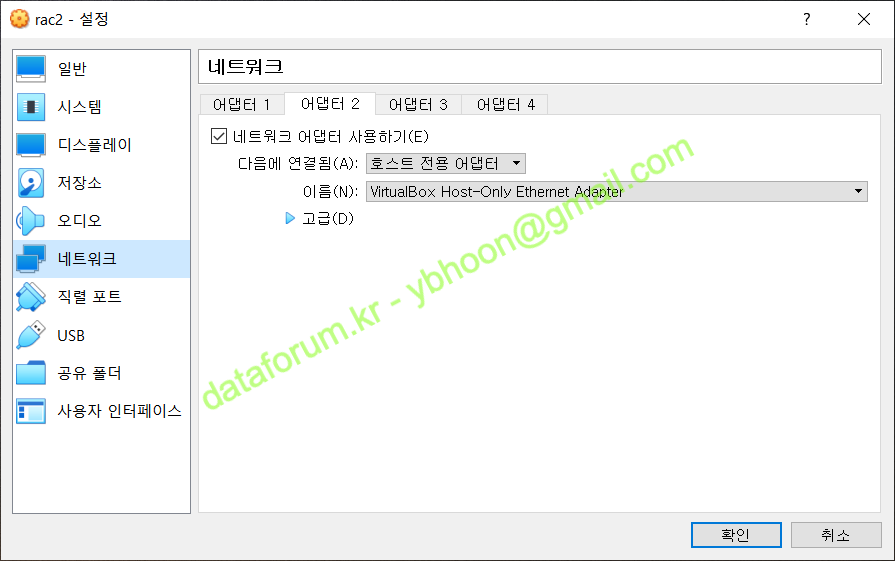

RAC 노드간의 통신을 위해 2번 어댑터를 활성화해야 합니다.

어댑터 2번 항목에 가서 '네트워크 어댑터 사용하기'를 체크합니다.

그리고, RAC 노드 내부에서만 사용할 것이므로 '호스트 전용 어댑터'를 클릭합니다.

사전에 VirtualBox의 호스트 전용 네트워크가 생성되어 있어야 합니다.

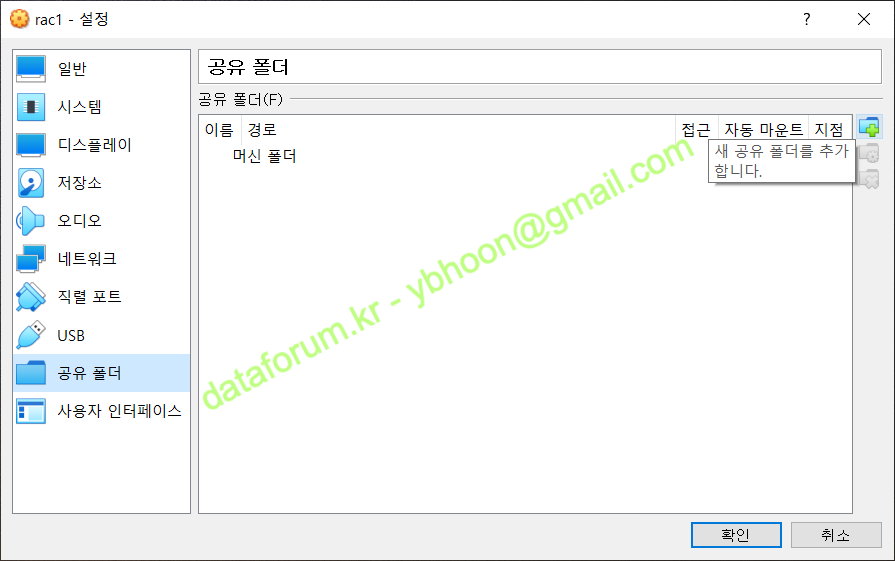

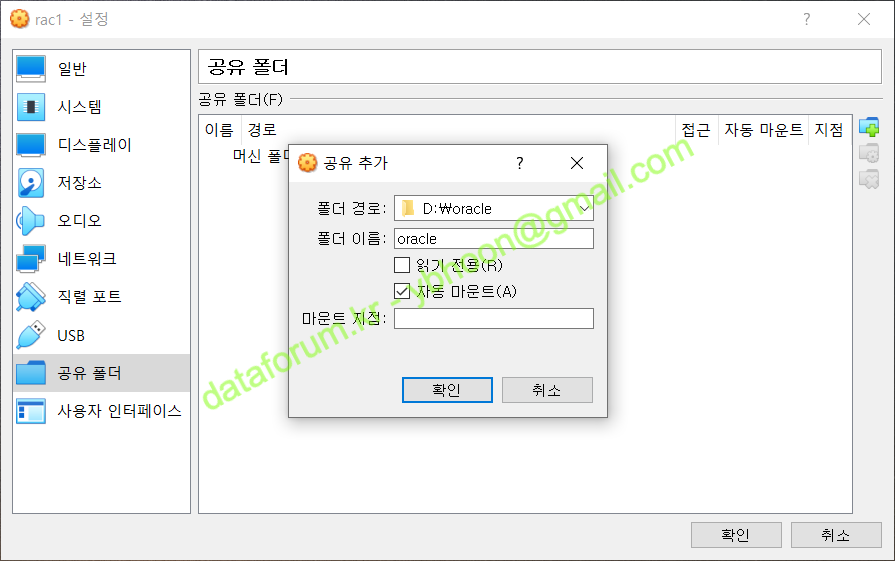

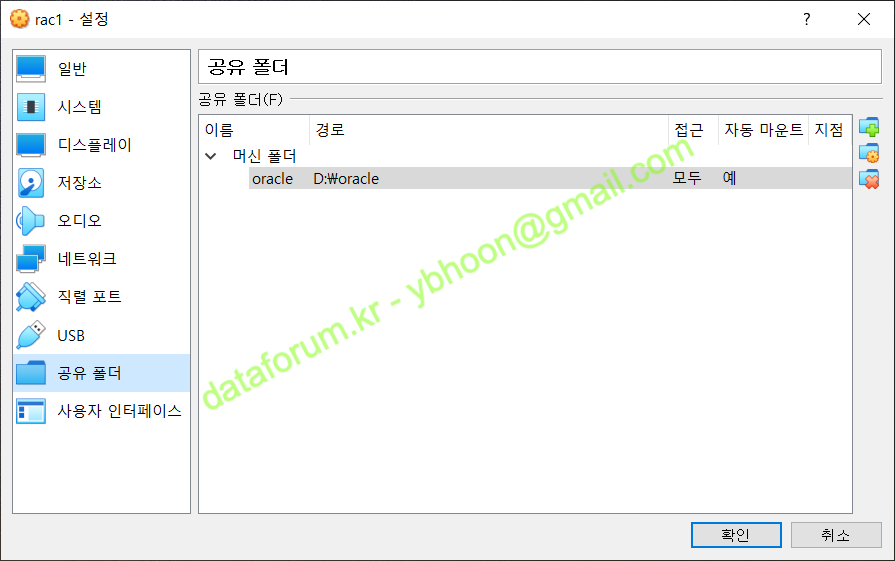

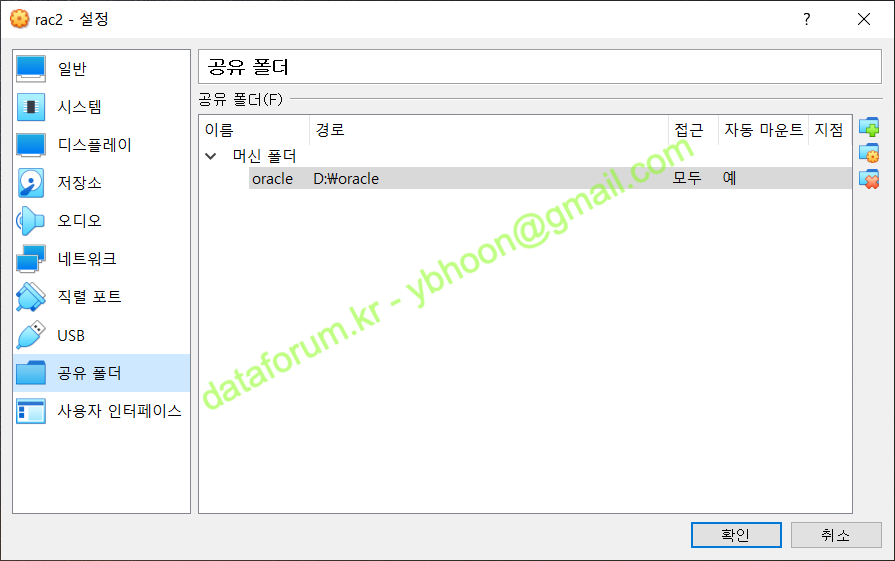

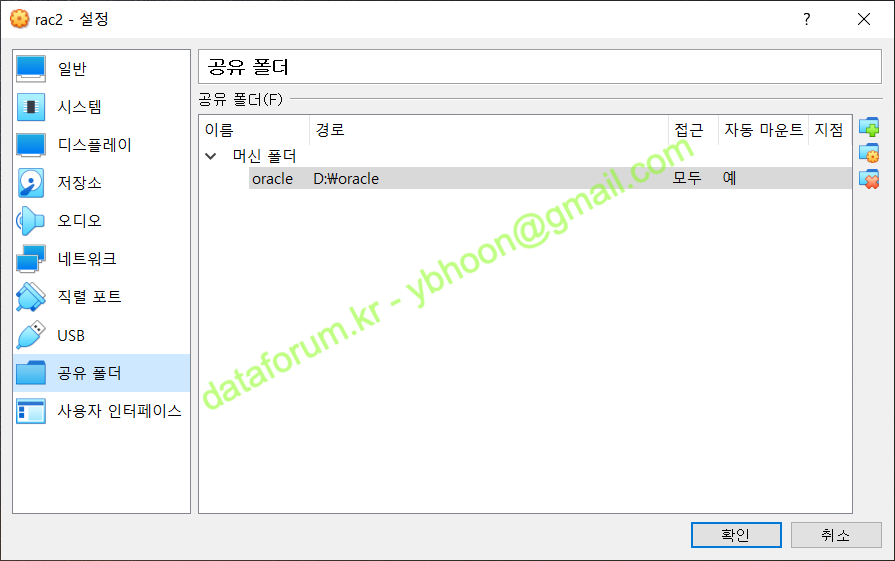

F) 공유 폴더

VirtualBox 상에서 Guest Additions 을 설치하면, 공유 폴더 기능을 사용할 수 있습니다.

공유 폴더를 설정할 경우, 호스트 서버에 저장된 설치 파일을 업로드 없이 바로 사용할 수 있습니다.

오른쪽에 폴더 모양에 '+' 표시가 있는 아이콘을 클릭합니다.

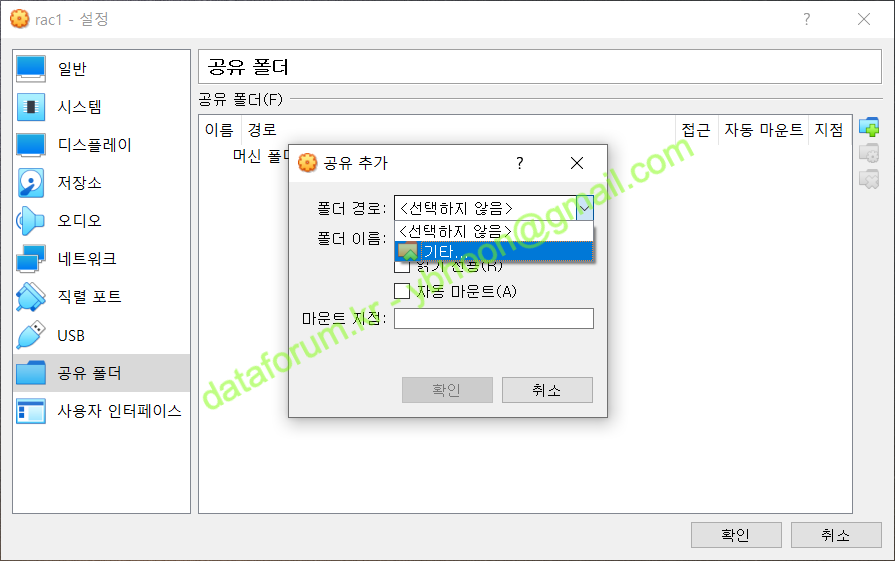

공유할 폴더를 입력하기 위해 폴더 경로에 '기타'를 선택합니다

공유할 폴더를 선택하고, 폴더 이름을 "oracle"로 지정하고 '자동 마운트'를 선택한 후 <OK>를 클릭합니다

설정 변경이 모두 완료되었으므로 <OK>를 클릭합니다.

리눅스 설치를 위해 <시작> 버튼을 클릭하면, 마운트된 리눅스 이미지로 가상 시스템이 부팅되며 OS 설치가 시작 됩니다.

III. Oracle Linux 7 설치

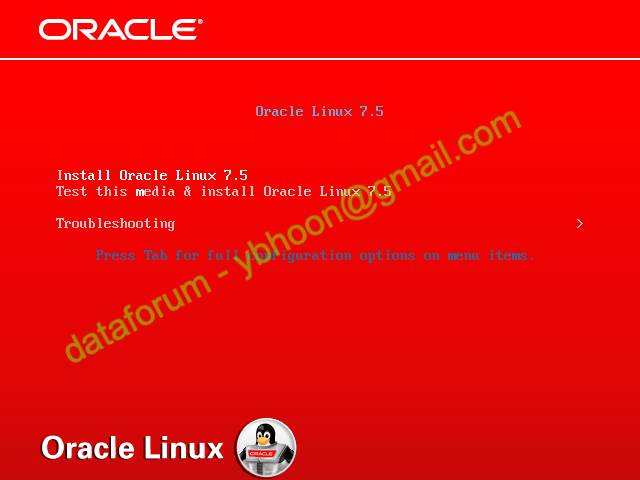

1. 부팅

A) 미디어 검사 여부 선택

설치 미디어에 대한 테스트 없이 바로 설치를 진행하려면 'Install Oracle Linux 7.x'를 키보드로 선택하고 "엔터"를 입력합니다.

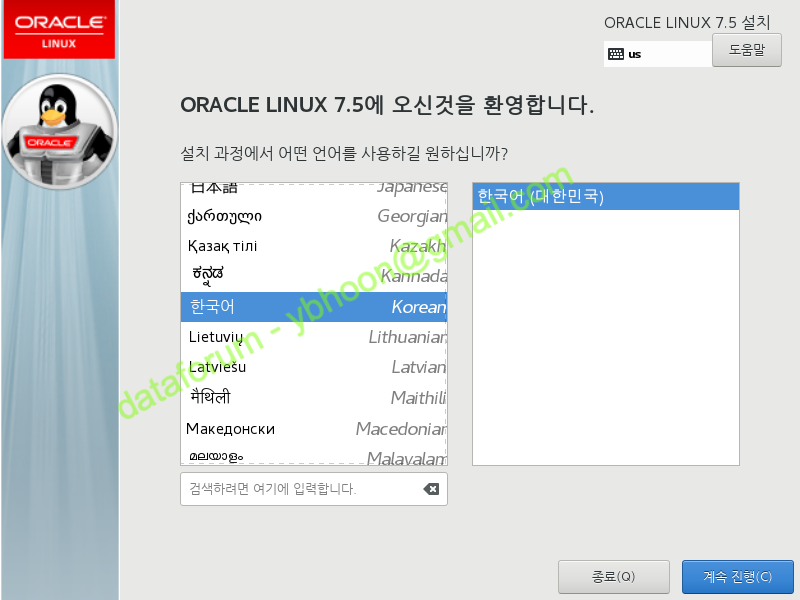

B) 언어 선택

실습의 편의를 위해 설치 언어는 '한국어'를 선택하고 <계속 진행>을 클릭합니다.

운영 환경에서는 이슈 발생시의 문제 해결이나 디버깅 등을 위해 영어로 설치하는 것을 권합니다.

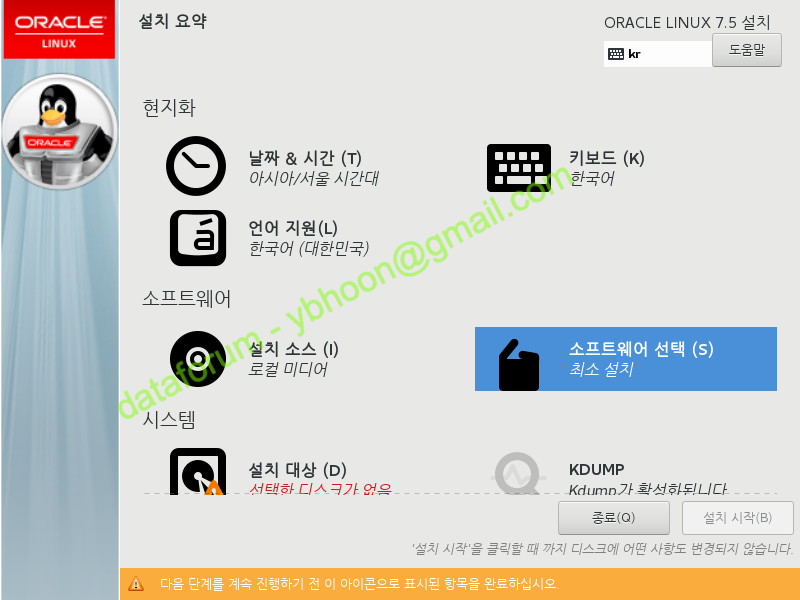

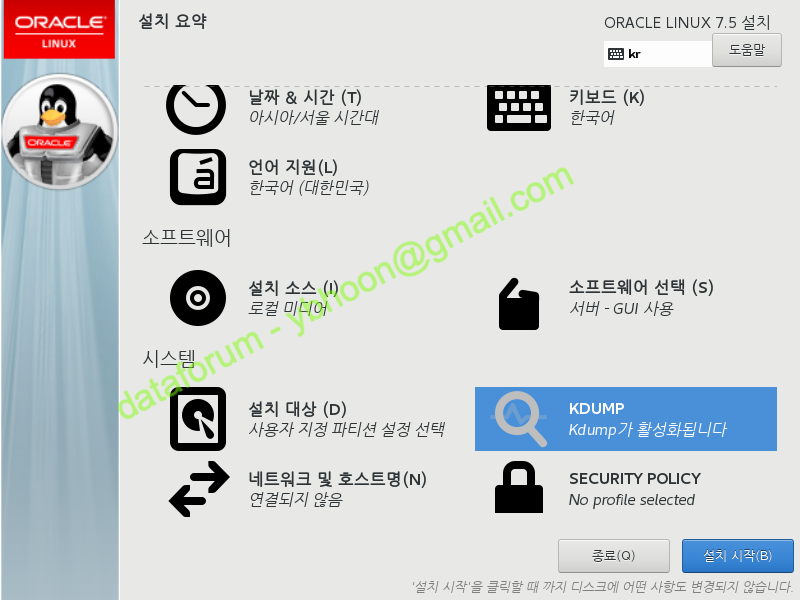

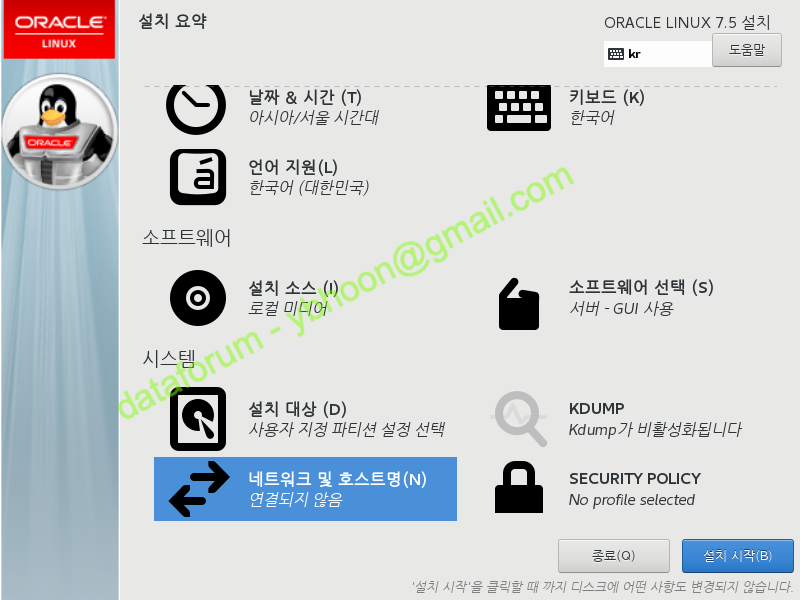

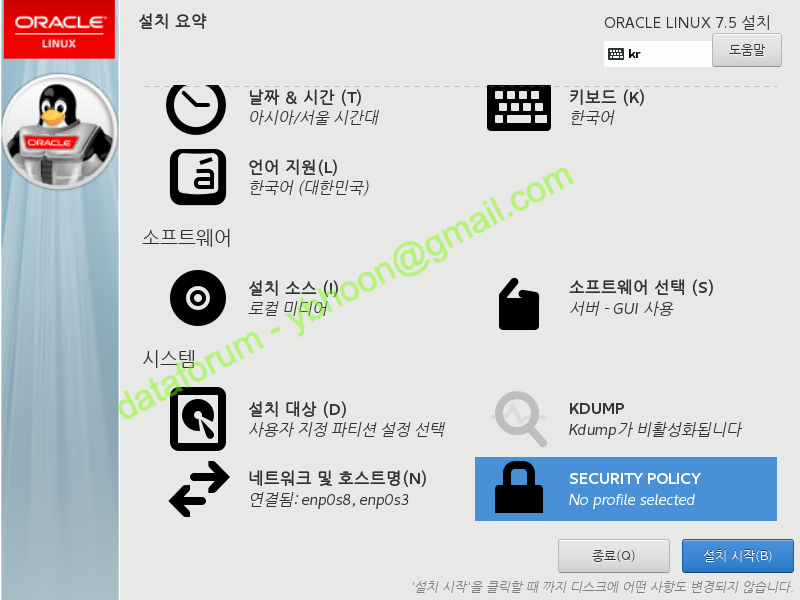

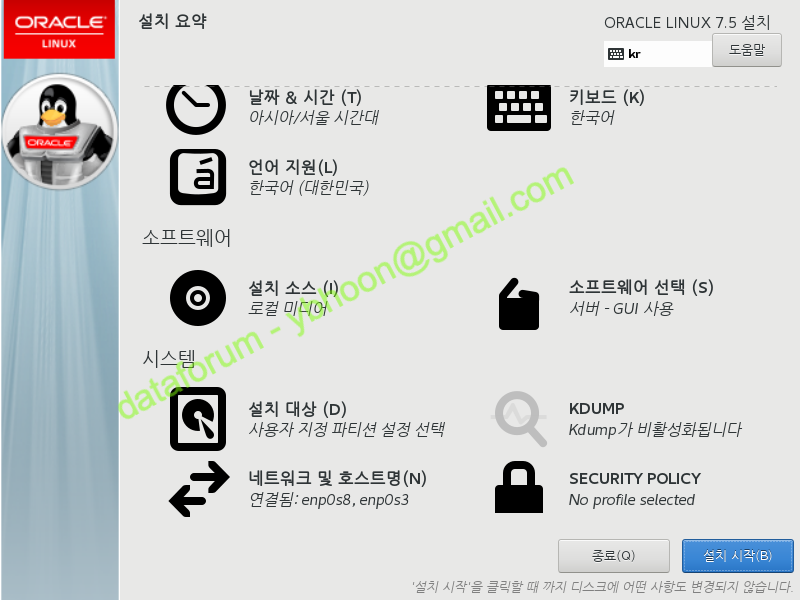

2. 설치 요약

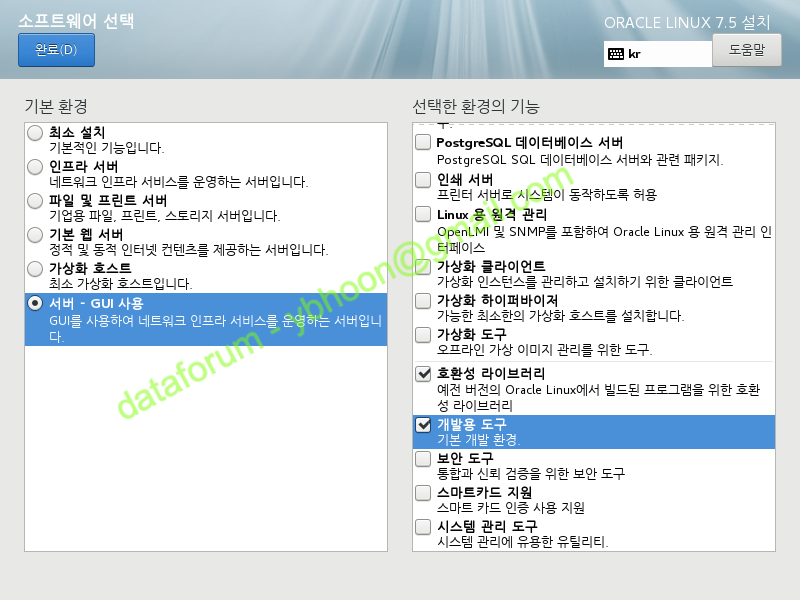

A) 소프트웨어 선택

설치 요약 화면입니다.

이 화면에서 각 항목별로 필요한 옵션을 수정한 후에 설치를 진행할 예정입니다.

먼저 '소프트웨어 선택' 항목을 클릭합니다.

서버에서 직접 GUI 모드로 설치하기 위해 '서버 - GUI 사용'을 선택하고, 우측의 '선택한 환경의 기능'에서 다음의 두 기능을 추가합니다.

- 호환성 라이브러리

- 개발용 도구

그리고 <완료>를 클릭합니다.

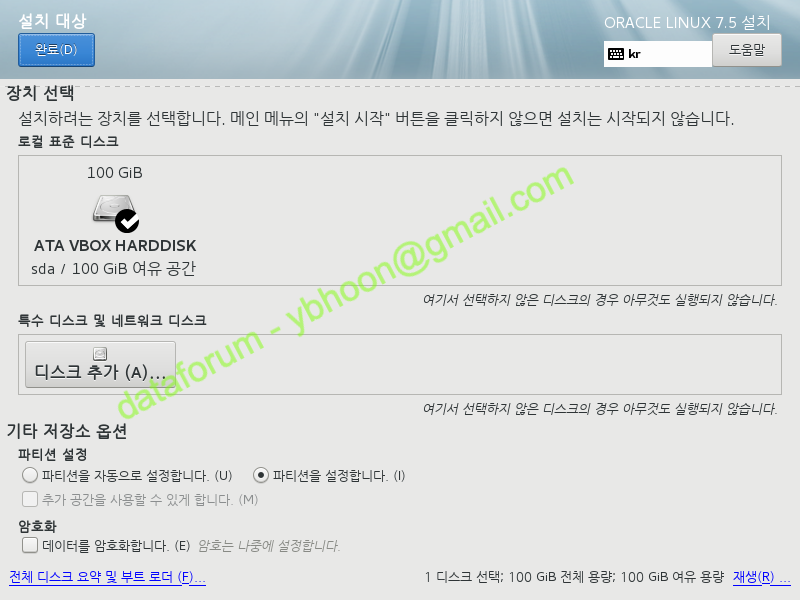

B) 설치 대상

다음으로 '설치 대상'을 수정합니다.

설치할 디스크를 체크하고 '파티션을 설정합니다'를 선택한 후에 <완료> 버튼을 클릭합니다.

C) 파티션 설정

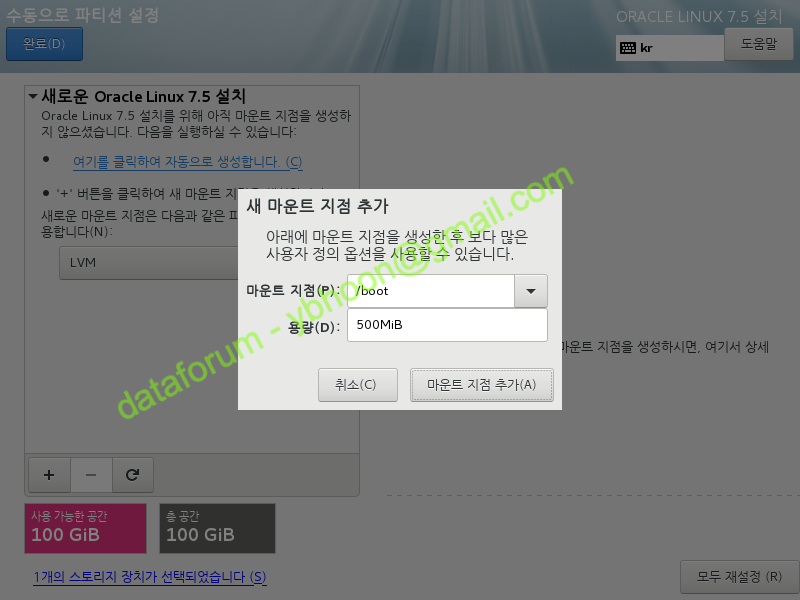

'수동으로 파티션 설정' 화면으로 전환됩니다.

'새로운 Oracle Linux 7.x 설치' 항목 좌측 하단에 <+> 버튼을 클릭하여 마운트 지점을 생성합니다

마운트 지점을 "/boot"로 지정하고 "500MiB"를 할당한 후 <마운트 지점 추가>를 클릭합니다.

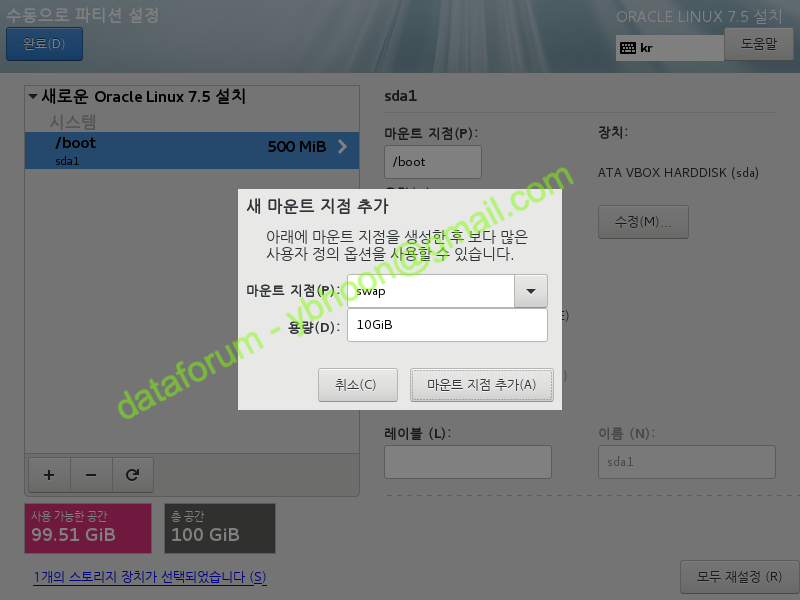

swap 영역도 <+> 버튼을 클릭하여 '새 마운트 지점 추가' 창을 연 후에 RAM 크기와 동일한 10GiB를 할당하고, <마운트 지점 추가> 버튼을 클릭합니다.

swap의 크기는 아래와 같이 크기를 할당할 수 있습니다.

| 물리 메모리(RAM) 크기 | swap 영역 크기 |

|---|---|

| 1GB~2GB | RAM의 1.5배 크기 |

| 2GB~16GB | RAM과 동일한 크기 |

| 16GB 이상 | 16GB |

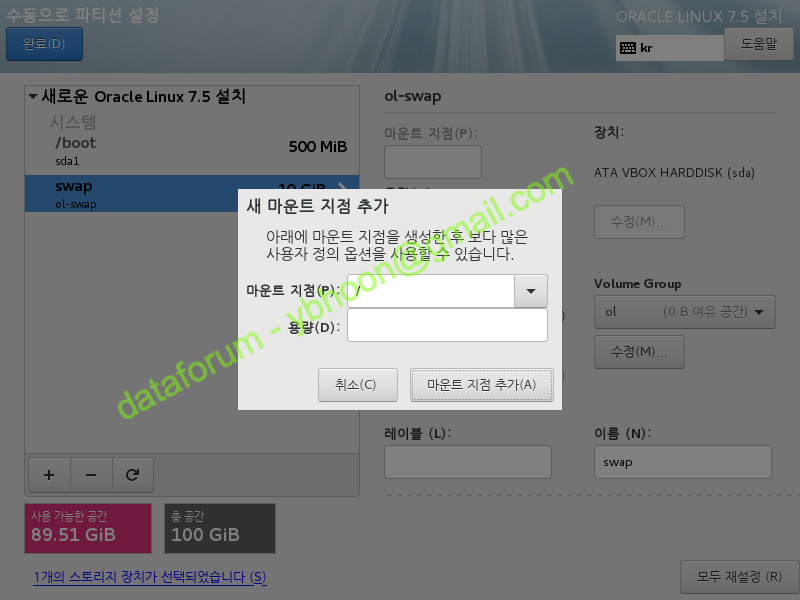

동일한 방식으로 나머지 공간을 "/"(root) 영역에 할당 합니다.

용량 항목을 빈 칸으로 입력한 후 <마운트 지점 추가>를 클릭하면 나머지 전체 영역이 할당됩니다.

각각의 마운트 지점이 아래와 같은 크기로 할당됩니다.

할당 영역 | 크기 |

|---|---|

| /boot | 200MB |

| swap | 10GB |

| / | 나머지 공간 할당 |

적용된 내용을 확인한 후에 <완료> 버튼을 클릭합니다.

변경 요약 화면이 나오면 <변경 사항 적용> 버튼을 클릭합니다.

D) KDUMP

실습을 위한 구축이므로 'KDUMP' 항목에서 kdump 기능을 비활성화하려 합니다.

'KDUMP' 항목으로 이동합니다.

'kdump 활성화'를 해제합니다.

운영 환경에서는 문제 해결 등의 이유로 활성화된 상태로 사용할 수 있으며, 운영 정책에 따라 지정해야 합니다.

필요한 옵션을 선택하였으면 <완료>를 클릭합니다

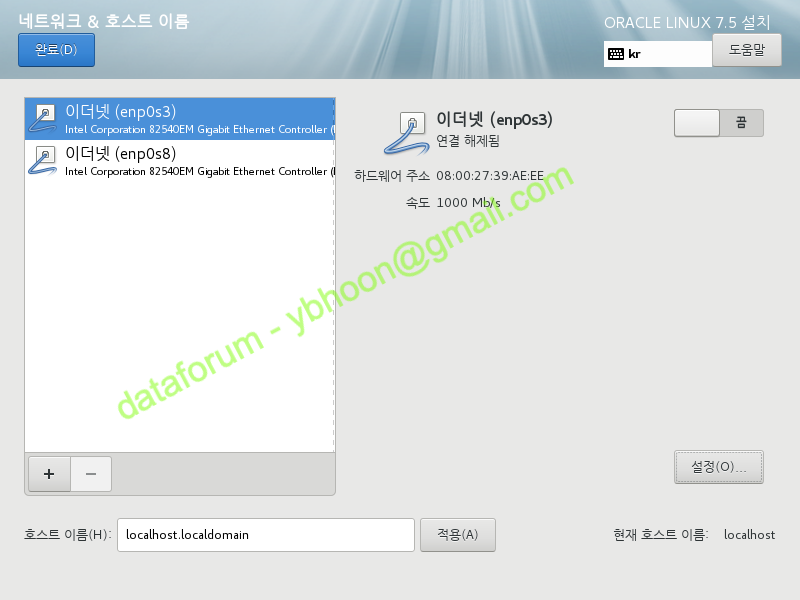

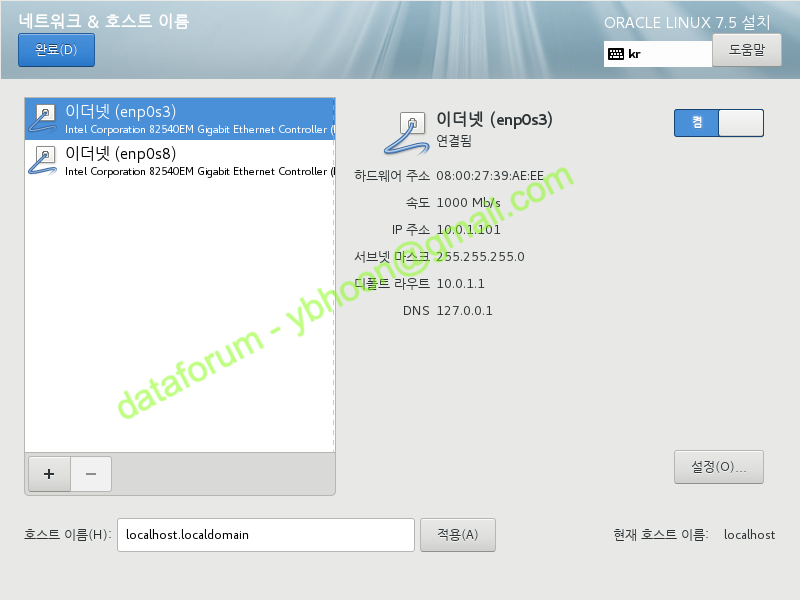

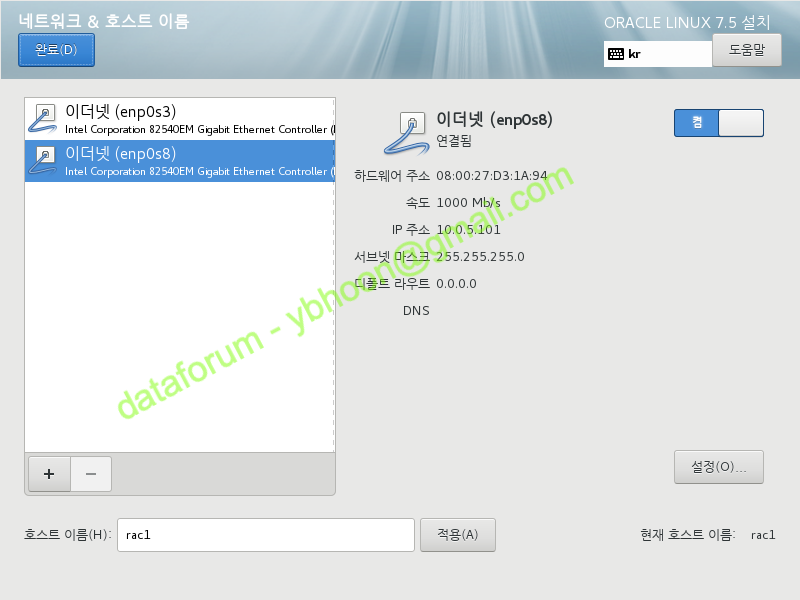

네트워크 및 호스트명

네트워크와 호스트명을 변경하기 위해 '네트워크 및 호스트명' 항목을 선택합니다.

네트워크와 호스트 이름을 설정해야 합니다.

좌측에서 Public 네트워크와 연결할 이더넷 인터페이스인 enp0s3을 선택하고 우측 하단의 <설정> 버튼을 클릭합니다.

VirtualBox가 아닌 VMware를 사용할 경우, 인터페이스 이름이 다를 수 있습니다.

네트워크 인터페이스명은 BIOS나 firmware를 기준으로 자동으로 생성됩니다.

RAC를 구성하는데 있어서, 모든 노드의 public 이더넷과 private 이더넷의 이름이 각 그룹내에서 동일해야 경고없이 설치나 패치를 진행할 수 있습니다.

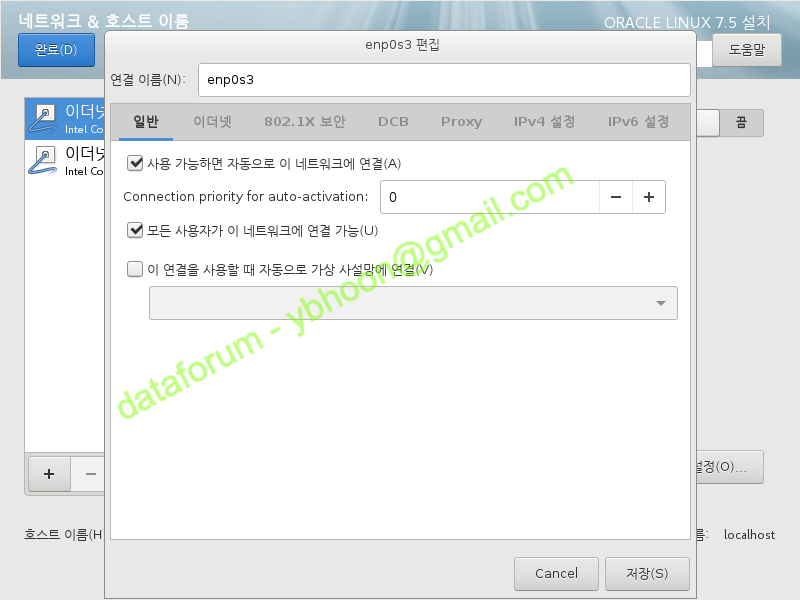

일반 탭에서 '사용 가능하면 자동으로 이 네트워크에 연결'을 체크합니다.

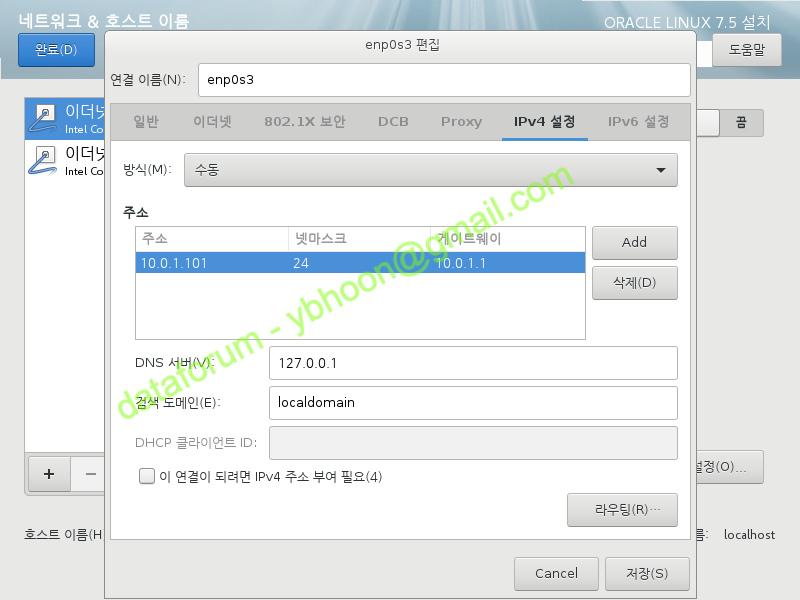

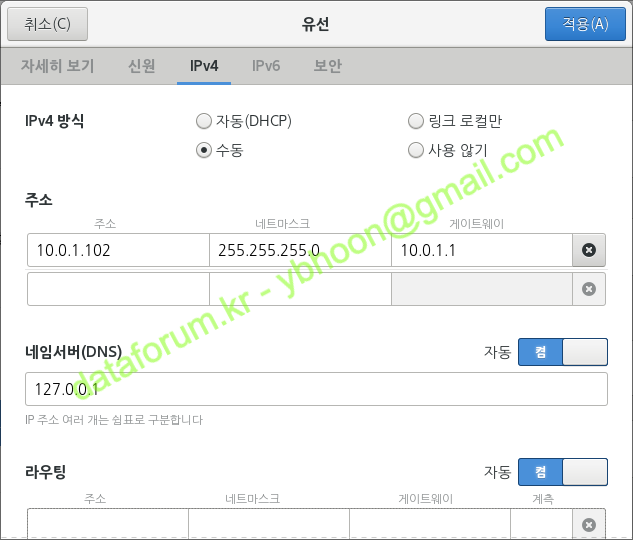

IPv4 설정 탭으로 이동하여 방식에 '수동'을 선택합니다.

'Add' 버튼을 클릭하고 다음의 정보를 입력합니다.

| 항목 | 입력값 | 비고 |

|---|---|---|

| 주소 | 10.0.1.101 | 1번 노드 Public IP 주소 |

| 넷마스크 | 24 | 서브넷 마스크 값으로 255.255.255.0 사용 가능 |

| 게이트웨이 | 10.0.1.1 | Public 망의 게이트웨이 |

| DNS 서버 | 127.0.0.1 | dnsmasq를 사용할 경우 loopback IP 사용 |

| 검색 도메인 | localdomain | 로컬 도메인 정보 입력 |

DNS가 없는 환경이어서 dnsmasq를 사용할 것이므로 DNS 서버에 "127.0.0.1"을 입력하였으나, 운영 환경에서는 적절한 DNS 주소 입력이 필요합니다.

IPv6는 사용하지 않을 것이므로 방식에 '무시'를 선택하고, <저장>을 클릭합니다.

이더넷(enp0s3)에 입력한 Public 네트워크 정보가 적용된 것을 확인할 수 있습니다.

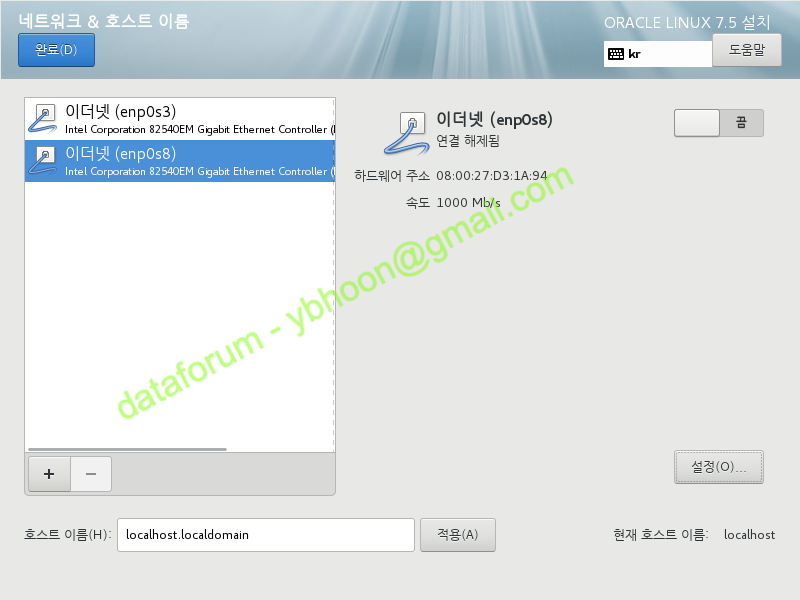

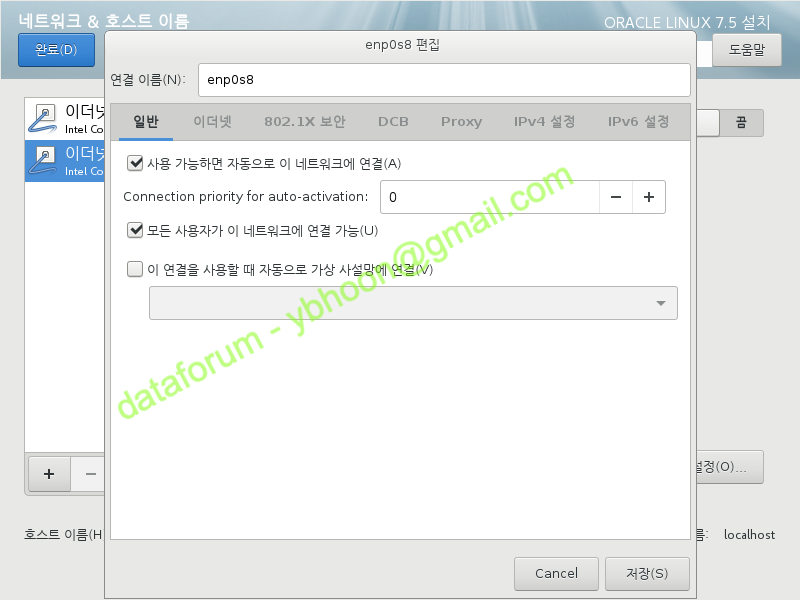

이번에는 좌측에서 Private 네트워크와 연결할 이더넷 인터페이스인 enp0s8을 선택하고 우측 하단의 <설정> 버튼을 클릭합니다.

일반 탭에서 '사용 가능하면 자동으로 이 네트워크에 연결'을 체크합니다.

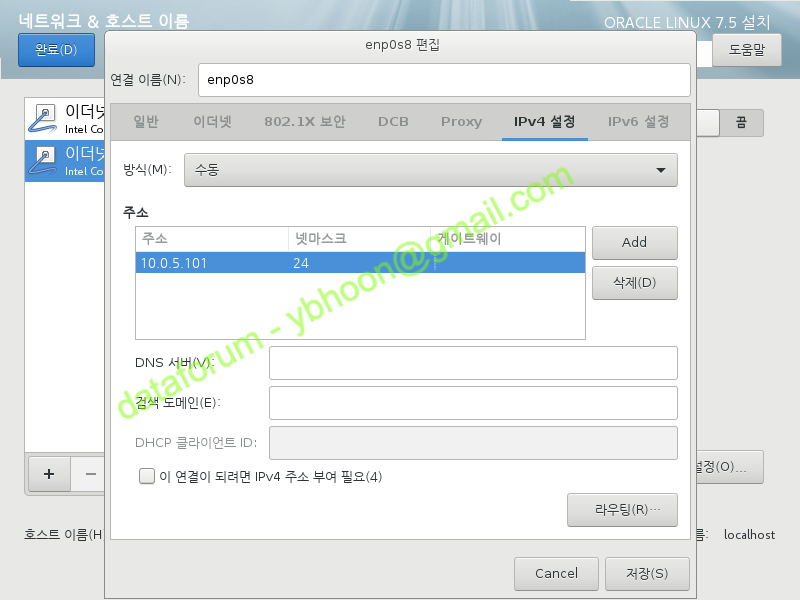

IPv4 설정 탭으로 이동하여 방식에 '수동'을 선택합니다.

'Add' 버튼을 클릭하고 다음의 정보를 입력합니다.

| 항목 | 입력값 | 비고 |

|---|---|---|

| 주소 | 10.0.5.101 | 1번 노드 Private IP 주소 |

| 넷마스크 | 24 | 서브넷 마스크 값으로 255.255.255.0 사용 가능 |

Private 망을 위한 설정으로 게이트웨이나 DNS값은 비워둡니다.

실습에서는 Private 연결에 별도의 장치를 구성하지는 않았지만, 운영 환경에서는 노드 간의 통신은 L2 이상의 장비를 통해 연결되어야 합니다. (오라클 권고)

IPv6는 사용하지 않을 것이므로 방식에 '무시'를 선택하고, <저장>을 클릭합니다.

이더넷(enp0s8)에 입력한 Private 네트워크 정보가 적용된 것을 확인할 수 있습니다.

좌측 하단에 서버에 사용될 호스트명을 입력하고 <적용>을 클릭합니다.

실습 환경에서는 1번 노드는 "rac1"을 사용할 것입니다.

네트워크 구성이 완료되었으므로 <완료> 버튼을 클릭합니다.

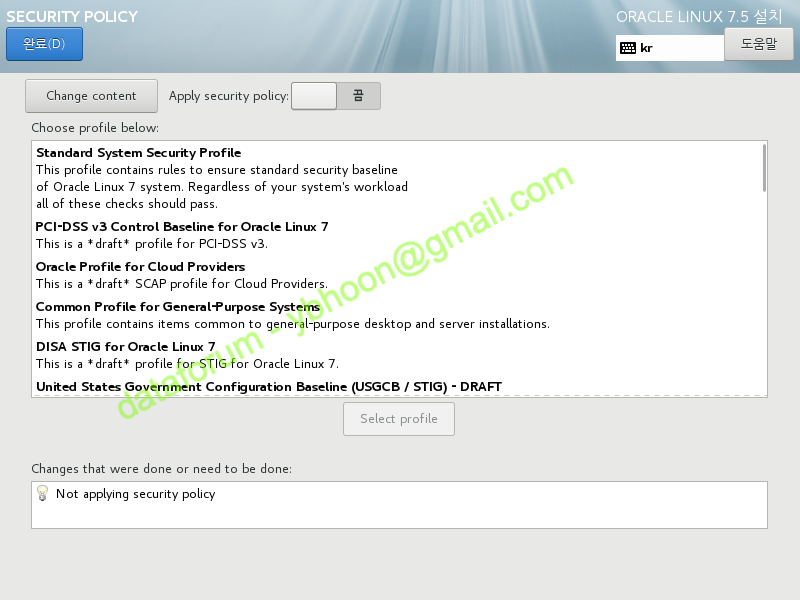

E) SECURITY POLICY

보안 관련 설정을 변경하기 위해 'SECURITY POLICY' 항목으로 이동합니다.

실습에서는 'SECURITY POLICY'의 모든 내용을 끄고 진행하겠습니다.

'Apply security policy'를 끄고 <완료>를 클릭합니다.

운영 환경에서는 보안 정책을 고려하여 설정을 변경할 것을 권고합니다.

설치를 위한 사전 준비가 모두 완료되었으므로 <설치 시작>을 클릭합니다.

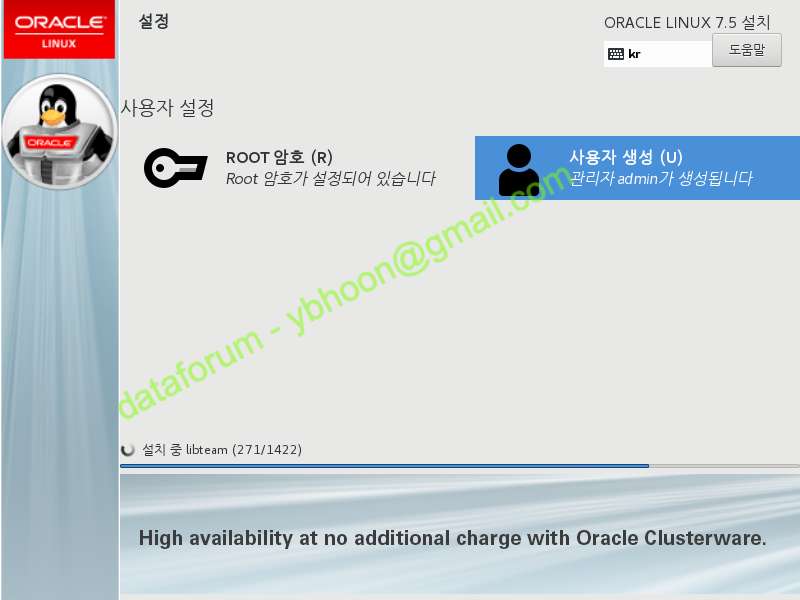

3. 사용자 설정

A) ROOT 암호

설치가 진행되는 중간에 root 계정의 암호와 추가 사용자를 생성할 수 있습니다.

먼저 'ROOT 암호'를 선택합니다.

적당한 암호를 입력하고 <완료> 버튼을 클릭합니다.

취약한 암호를 사용할 경우에는 <완료> 버튼을 2번 클릭해야 합니다.

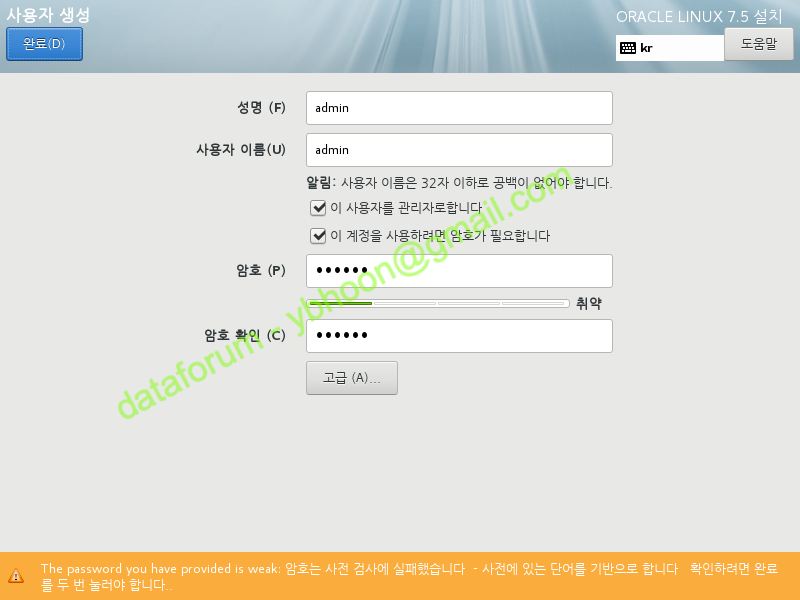

B) 사용자 생성

'사용자 생성'에서는 root와는 별개의 관리자 권한을 생성하겠습니다.

리눅스 7버전에서는 별도의 관리자 계정을 생성하여 사용하는 것을 권하고 있습니다.

추가할 관리자 계정의 정보를 입력하고 <완료> 버튼을 클릭합니다.

OS 설치가 진행되는 동안 기다립니다.

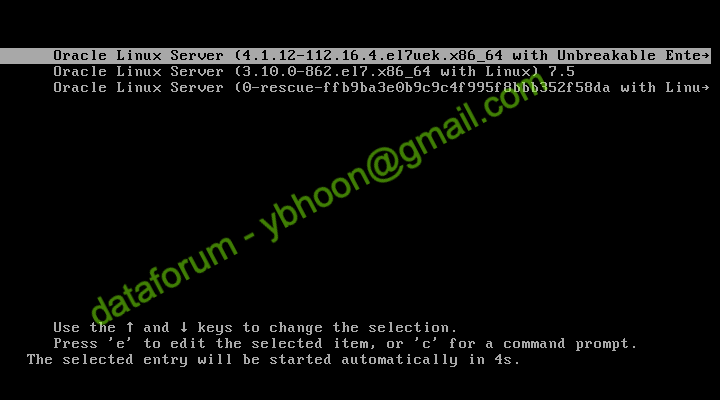

4. 재부팅

설치가 완료되면 <재부팅> 버튼을 클릭합니다.

가상 머신이 재부팅됩니다.

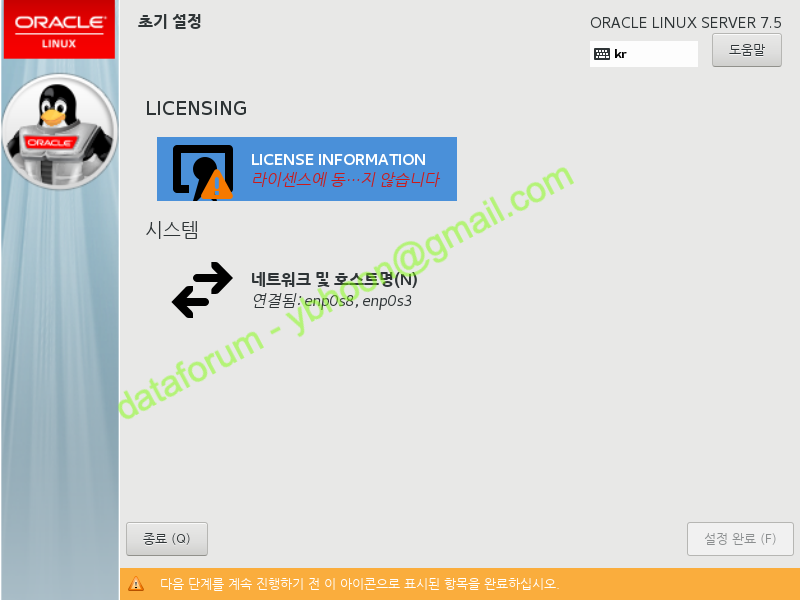

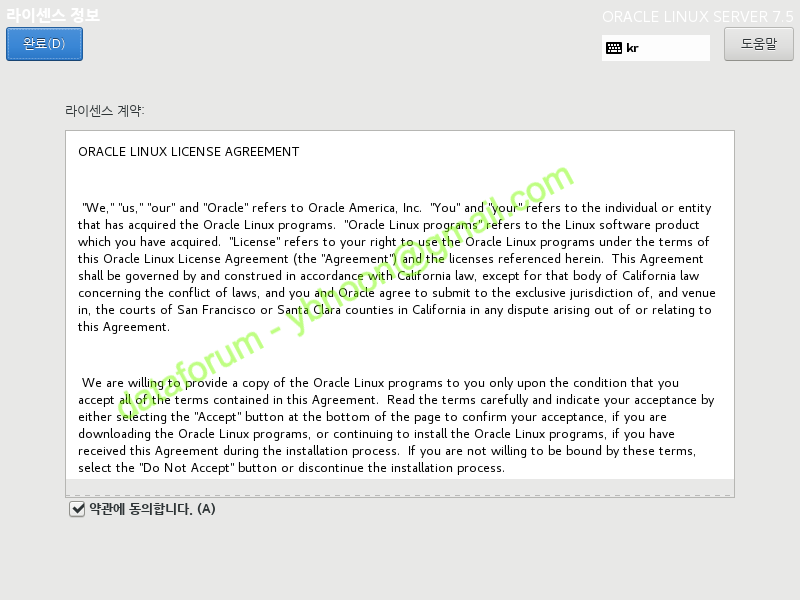

A) LICENSE INFORMATION

재부팅 화면에서 'LICENSE INFORMATION'을 클릭하여 라이센스 동의를 진행합니다.

'약관에 동의합니다'를 체크하고 <완료>를 클릭합니다.

모든 구성이 완료되었으므로 본격적인 사용을 위해 <설정 완료>를 클릭합니다.

{}

IV. 리눅스 환경 설정

1. GUI 접속 환경 설정

A) root 계정 접속

VirtualBox를 사용하는 실습 환경에서는 편의를 위해 Guest Addition을 설치하는 것이 좋습니다.

VMware라면 VMware Tools를 설치할 수 있습니다.

물론 가상머신을 사용하지 않는 운영 환경에서는 이 방법을 사용할 수 없고, ftp나 sftp 등의 방식으로 파일을 서버에 업로드해야 합니다.

root 유저로 접속하기 위해서 초기 접속 화면에 '목록에 없습니까?'를 클릭합니다.

사용자 이름에 "root"를 입력하고 <다음>을 클릭합니다.

암호에 root 계정의 암호를 입력하고 <다음>을 클릭합니다.

처음 접속시 환영 메시지와 함께 초기 설정 화면이 나옵니다.

언어를 '한국어'로 선택한 상태에서 <다음>을 클릭합니다.

운영 환경에서는 영어(English)를 사용하는 것을 권합니다.

키보드 배치에 '한국어'가 선택된 상태에서 <다음>을 클릭합니다.

위치 정보 서비스를 '끔'으로 변경하고 <다음>을 클릭합니다.

온라인 계정 설정 화면에서 <건너뛰기>를 클릭합니다.

마지막으로 'Oracle Linux Server 시작'을 클릭하면, 초기 설정 창이 닫힙니다.

시작하기란 새로운 창이 열리면 창 우측 상단의 'x' 표시를 클릭하여 닫아 줍니다.

GUI 모드로 다른 계정에 처음 접속할 때도, 동일한 방식으로 접속을 진행하면 됩니다.

B) VirtualBox Guest Additions 설치

호스트 머신의 VirtualBox 메뉴에서 '장치' > '게스트 확장 CD 이미지 삽입'을 클릭하여, Guest Additions CD를 가상머신에 mount 시켜줍니다

설치 미디어가 인식되면 자동 시작 프로그램에 대한 안내 창이 뜹니다.

설치를 진행하기 위해 <실행>을 클릭합니다.

Guest Additions이 정상적으로 설치되었으면, 마운트 된 설치 이미지를 eject 해야 합니다.

바탕화면을 마우스 우측 버튼으로 클릭하면 드롭다운 메뉴가 펼쳐지며, '터미널 열기'를 클릭하면 됩니다.

터미널에서 eject 명령어로 이미지를 해제한 후, 가상머신의 디스플레이 설정을 변경하기 위해서 shutdown 명령어로 서버를 중지합니다.

가상머신의 설정 메뉴에서 디스플레이의 그래픽 컨트롤러를 'VMSVGA'로 원복한 후에 가상 머신을 다시 기동합니다.

자동 설치 스크립트가 실행되며, VM에 Guest Addition이 설치됩니다.

설치가 완료되면 "엔터"를 입력하여 실행 창을 닫아줍니다.

C) 화면 해상도 변경

가상 머신을 설치하게 되면 기본 화면 크기가 800*600으로 설정되어 있습니다.

OUI 로 설치를 진행하기 위해서는 화면의 해상도를 변경해야 합니다.

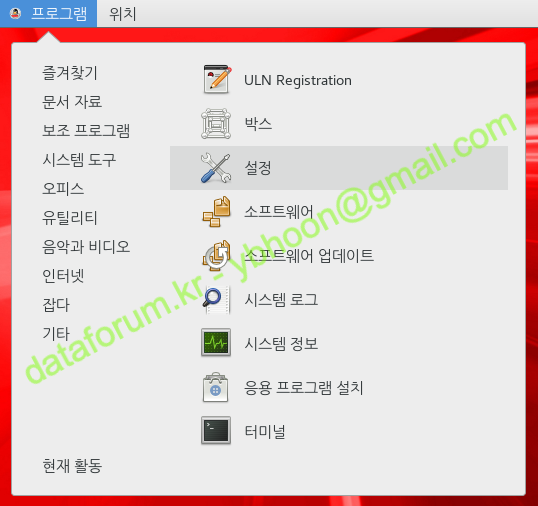

메뉴바에서 '프로그램' > '시스템 도구' > '설정'을 클릭합니다.

좌측의 항목 중에서 '장치'를 클릭합니다.

장치 목록에서 '디스플레이'를 선택한 후, '해상도' 부분을 클릭합니다.

해상도를 선택할 수 있는 창이 열리면 '1024x768' 이상의 화면 크기롤 선택합니다.

원하는 해상도를 선택하였으면 우측 상단의 <적용> 버튼을 클릭하여, 선택한 값으로 해상도가 변경되도록 합니다.

정상적으로 화면이 출력된다면, 디스클레이 설정 유지 여부를 뭍는 창에서 '바뀐 사항 유지'를 클릭하면 변경된 해상도로 계속 사용할 수 있게 됩니다.

2. 리눅스 환경 설정

A) 설치 정보 확인

uname -a cat /etc/oracle-release

[root@rac1 ~]# uname -a Linux rac1 4.14.35-1818.3.3.el7uek.x86_64 #2 SMP Mon Sep 24 14:45:01 PDT 2018 x86_64 x86_64 x86_64 GNU/Linux [root@rac1 ~]# cat /etc/oracle-release Oracle Linux Server release 7.6

먼저 설치된 리눅스의 버전 정보를 확인합니다.

B) 미사용 서비스 정리

### 방화벽 중지 systemctl stop firewalld systemctl disable firewalld ### 블루투스 중지 systemctl stop bluetooth systemctl disable bluetooth ### 시간 동기화 중지 systemctl stop chronyd systemctl disable chronyd mv /etc/chrony.conf /etc/chrony.conf.bak ### NTP 중지 systemctl stop ntpdate systemctl disable ntpdate ### AVAHI 중지 systemctl stop avahi-daemon.socket systemctl disable avahi-daemon.socket systemctl stop avahi-daemon systemctl disable avahi-daemon ### 가상 시스템 관리 중지 systemctl stop libvirtd systemctl disable libvirtd

[root@rac1 ~]# systemctl stop firewalld [root@rac1 ~]# systemctl disable firewalld Removed symlink /etc/systemd/system/multi-user.target.wants/firewalld.service. Removed symlink /etc/systemd/system/dbus-org.fedoraproject.FirewallD1.service. [root@rac1 ~]# systemctl stop bluetooth [root@rac1 ~]# systemctl disable bluetooth Removed symlink /etc/systemd/system/dbus-org.bluez.service. Removed symlink /etc/systemd/system/bluetooth.target.wants/bluetooth.service. [root@rac1 ~]# systemctl stop chronyd [root@rac1 ~]# systemctl disable chronyd Removed symlink /etc/systemd/system/multi-user.target.wants/chronyd.service. [root@rac1 ~]# mv /etc/chrony.conf /etc/chrony.conf.bak [root@rac1 ~]# systemctl stop ntpdate [root@rac1 ~]# systemctl disable ntpdate [root@rac1 ~]# systemctl stop avahi-daemon.socket [root@rac1 ~]# systemctl disable avahi-daemon.socket Removed symlink /etc/systemd/system/sockets.target.wants/avahi-daemon.socket. [root@rac1 ~]# systemctl stop avahi-daemon [root@rac1 ~]# systemctl disable avahi-daemon Removed symlink /etc/systemd/system/multi-user.target.wants/avahi-daemon.service. Removed symlink /etc/systemd/system/dbus-org.freedesktop.Avahi.service. [root@rac1 ~]# systemctl stop libvirtd [root@rac1 ~]# systemctl disable libvirtd Removed symlink /etc/systemd/system/multi-user.target.wants/libvirtd.service. Removed symlink /etc/systemd/system/sockets.target.wants/virtlogd.socket. Removed symlink /etc/systemd/system/sockets.target.wants/virtlockd.socket.

테스트 환경에서 사용하지 않는 서비스를 정리합니다.

실습 환경에서는 CTSS를 활성화 모드로 운영할 것이므로 NTP나 chrony 등의 시간 동기화 서비스를 중지할 것입니다.

그러나 실제 운영환경에서는 구성 환경을 고려하여 사용 여부를 결정해야하며, 가급적 NTP를 설정(-x 포함)하여 사용하는 것을 권장합니다.

C) 리눅스 제공 필수 패키지 설치

cd <리눅스 설치 디스크 마운트 경로>/Packages rpm -ivh ksh-*.x86_64.rpm rpm -ivh libaio-devel-*.x86_64.rpm # rpm -ivh kmod-oracleasm-*.x86_64.rpm rpm -ivh oracleasm-support-*.x86_64.rpm cd eject

[root@rac1 ~]# cd /run/media/root/OL-7.6\ Server.x86_64/Packages [root@rac1 Packages]# rpm -ivh ksh-20120801-139.0.1.el7.x86_64.rpm 경고: ksh-20120801-139.0.1.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:ksh-20120801-139.0.1.el7 ################################# [100%] [root@rac1 Packages]# rpm -ivh libaio-devel-0.3.109-13.el7.x86_64.rpm 경고: libaio-devel-0.3.109-13.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:libaio-devel-0.3.109-13.el7 ################################# [100%] [root@rac1 Packages]# rpm -ivh oracleasm-support-2.1.11-2.el7.x86_64.rpm 경고: oracleasm-support-2.1.11-2.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:oracleasm-support-2.1.11-2.el7 ################################# [100%] 알림: 'systemctl enable oracleasm.service'에 요청을 전송하고 있습니다. Created symlink from /etc/systemd/system/multi-user.target.wants/oracleasm.service to /usr/lib/systemd/system/oracleasm.service. [root@rac1 Packages]# cd [root@rac1 ~]# eject

리눅스 설치시에 기본적으로 설치된 패키지 외에 추가로 3개의 패키지를 설치해야 합니다.

리눅스 설치 이미지를 mount한 후에 Package 디렉토리로 이동하여 패키지를 설치합니다.

설치가 완료되면 설치 이미지 밖의 경로로 이동한 후에 이미지를 eject 시켜줍니다.

그러지 않을 경우, 재부팅시 다시 리눅스 설치 화면으로 돌아오게 됩니다.

Red Hat Enterprise Linux 사용시에는 kmod-oracleasm 패키지도 추가로 설치합니다.

rpm -q binutils rpm -q compat-libcap1 rpm -q compat-libstdc++-33 rpm -q glibc rpm -q glibc-devel rpm -q ksh rpm -q libaio rpm -q libaio-devel rpm -q libgcc rpm -q libstdc++ rpm -q libstdc++-devel rpm -q libX11 rpm -q libXau rpm -q libxcb rpm -q libXi rpm -q libXtst rpm -q make rpm -q net-tools rpm -q nfs-utils rpm -q smartmontools rpm -q sysstat

[root@rac1 ~]# rpm -q binutils binutils-2.27-34.base.0.1.el7.x86_64 [root@rac1 ~]# rpm -q compat-libcap1 compat-libcap1-1.10-7.el7.x86_64 [root@rac1 ~]# rpm -q compat-libstdc++-33 compat-libstdc++-33-3.2.3-72.el7.x86_64 [root@rac1 ~]# rpm -q glibc glibc-2.17-260.0.9.el7.x86_64 [root@rac1 ~]# rpm -q glibc-devel glibc-devel-2.17-260.0.9.el7.x86_64 [root@rac1 ~]# rpm -q ksh ksh-20120801-139.0.1.el7.x86_64 [root@rac1 ~]# rpm -q libaio libaio-0.3.109-13.el7.x86_64 [root@rac1 ~]# rpm -q libaio-devel libaio-devel-0.3.109-13.el7.x86_64 [root@rac1 ~]# rpm -q libgcc libgcc-4.8.5-36.0.1.el7.x86_64 [root@rac1 ~]# rpm -q libstdc++ libstdc++-4.8.5-36.0.1.el7.x86_64 [root@rac1 ~]# rpm -q libstdc++-devel libstdc++-devel-4.8.5-36.0.1.el7.x86_64 [root@rac1 ~]# rpm -q libX11 libX11-1.6.5-2.el7.x86_64 [root@rac1 ~]# rpm -q libXau libXau-1.0.8-2.1.el7.x86_64 [root@rac1 ~]# rpm -q libxcb libxcb-1.13-1.el7.x86_64 [root@rac1 ~]# rpm -q libXi libXi-1.7.9-1.el7.x86_64 [root@rac1 ~]# rpm -q libXtst libXtst-1.2.3-1.el7.x86_64 [root@rac1 ~]# rpm -q make make-3.82-23.el7.x86_64 [root@rac1 ~]# rpm -q net-tools net-tools-2.0-0.24.20131004git.el7.x86_64 [root@rac1 ~]# rpm -q nfs-utils nfs-utils-1.3.0-0.61.0.1.el7.x86_64 [root@rac1 ~]# rpm -q smartmontools smartmontools-6.5-1.el7.x86_64 [root@rac1 ~]# rpm -q sysstat sysstat-10.1.5-17.el7.x86_64

오라클 설치에 필요한 리눅스 패키지들이 모두 설치되어 있는지 검증합니다.

누락된 패키지가 있다면 반드시 설치해야 합니다.

패키지 파일은 yum을 이용하여 직접 설치하거나 Oracle Linux Repository에서 다운로드 할 수 있습니다.

https://public-yum.oracle.com/repo/OracleLinux/OL7/latest/x86_64/index.html

Red Hat Enterprise Linux 사용시에는 별도로 compat-libstdc++-33 패키지 설치가 필요합니다.

D) 11g 구축을 위한 추가 패키지 설치

rpm -ivh zlib-devel-*.x86_64.rpm rpm -ivh elfutils-libelf-devel-*.x86_64.rpm

[root@rac1 Packages]# rpm -ivh zlib-devel-1.2.7-18.el7.x86_64.rpm 경고: zlib-devel-1.2.7-18.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:zlib-devel-1.2.7-18.el7 ################################# [100%] [root@rac1 Packages]# rpm -ivh elfutils-libelf-devel-0.176-2.el7.x86_64.rpm 경고: elfutils-libelf-devel-0.176-2.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:elfutils-libelf-devel-0.176-2.el7################################# [100%]

Database 11g 설치를 위해 필요한 elfutils-libelf-devel 패키지와 이에 필요한 zlib-devel 패키지를 설치합니다.

E) hosts 파일 수정

### Public 10.0.1.101 rac1 rac1.localdomain 10.0.1.102 rac2 rac2.localdomain ### Private 10.0.5.101 rac1-priv rac1-priv.localdomain 10.0.5.102 rac2-priv rac2-priv.localdomain ### Virtual 10.0.1.201 rac1-vip rac1-vip.localdomain 10.0.1.202 rac2-vip rac2-vip.localdomain ### SCAN 10.0.1.191 rac-scan rac-scan.localdomain 10.0.1.192 rac-scan rac-scan.localdomain 10.0.1.193 rac-scan rac-scan.localdomain

/etc/hosts 파일에 설치할 모든 서버의 IP와 호스트명을 추가합니다.

오라클 소프트웨어 설치를 정상적으로 진행하기 위해 로컬 노드와 원격 노드에 대한 정보를 정확히 입력해야 합니다.

SCAN IP는 1개만 할당해도 설치에 지장은 없습니다. 다만, 18c부터는 3개를 할당하지 않을 경우, 필요 조건 검사 과정에서 검증 실패 메시지가 출력됩니다.

F) 보안 설정 변경

SELINUX=permissive

setenforce permissive

Selinux 모드를 permissive로 변경합니다.

G) dnsmasq 활성화

local=/localdomain/

dnsmasq 서비스의 환경 설정 파일에 로컬 도메인에 대한 정보를 입력합니다.

cat /etc/resolv.conf systemctl start dnsmasq systemctl enable dnsmasq nslookup rac-scan.localdomain # 경우에 따라 재기동 필요

[root@rac1 ~]# cat /etc/resolv.conf # Generated by NetworkManager search localdomain nameserver 127.0.0.1 [root@rac1 ~]# systemctl start dnsmasq [root@rac1 ~]# systemctl enable dnsmasq Created symlink from /etc/systemd/system/multi-user.target.wants/dnsmasq.service to /usr/lib/systemd/system/dnsmasq.service. [root@rac1 ~]# nslookup rac-scan.localdomain Server: 127.0.0.1 Address: 127.0.0.1#53 Name: rac-scan.localdomain Address: 10.0.1.191 Name: rac-scan.localdomain Address: 10.0.1.192 Name: rac-scan.localdomain Address: 10.0.1.193 [root@rac1 ~]# nslookup rac-scan.localdomain Server: 127.0.0.1 Address: 127.0.0.1#53 Name: rac-scan.localdomain Address: 10.0.1.192 Name: rac-scan.localdomain Address: 10.0.1.193 Name: rac-scan.localdomain Address: 10.0.1.191 [root@rac1 ~]# nslookup rac-scan.localdomain Server: 127.0.0.1 Address: 127.0.0.1#53 Name: rac-scan.localdomain Address: 10.0.1.193 Name: rac-scan.localdomain Address: 10.0.1.191 Name: rac-scan.localdomain Address: 10.0.1.192

별도의 DNS 서비스 없이 SCAN을 사용하기 위해 dnsmasq 서비스를 활성화합니다.

DNS 설정 파일(resolv.conf)에는 "nameserver 127.0.0.1"가 입력되어 있어야 합니다.

H) 가상 메모리 파일 시스템 할당

tmpfs /dev/shm tmpfs size=8g 0 0

mount -o remount /dev/shm

tmpfs /dev/shm tmpfs size=8g 0 0

[root@rac1 ~]# mount -o remount /dev/shm [root@rac1 ~]# df -h | grep shm tmpfs 8.0G 84K 8.0G 1% /dev/shm

가상 메모리 파일 시스템(tmpfs) 값을 설정하고 remount하여 적용시킵니다.

I) oracle 제공 추가 패키지 설치

rpm -ivh oracle-database-preinstall-19c-*.x86_64.rpm rpm -ivh oracleasmlib-*.x86_64.rpm

[root@rac1 tmp]# rpm -ivh oracle-database-preinstall-19c-1.0-1.el7.x86_64.rpm 경고: oracle-database-preinstall-19c-1.0-1.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:oracle-database-preinstall-19c-1.################################# [100%] [root@rac1 tmp]# rpm -ivh oracleasmlib-2.0.12-1.el7.x86_64.rpm 경고: oracleasmlib-2.0.12-1.el7.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID ec551f03: NOKEY 준비 중... ################################# [100%] Updating / installing... 1:oracleasmlib-2.0.12-1.el7 ################################# [100%]

추가로 Oracle Database 설치를 위한 preinstall 패키지와 ASMLib 패키지를 설치합니다.

preinstall 패키지는 Oracle Linux Repository에서 받을 수 있고, ASMLib 패키지는 아래 경로에서 다운로드 합니다.

https://www.oracle.com/technetwork/server-storage/linux/asmlib/rhel7-2773795.html

J) 그룹 및 사용자 계정 작업

### 그룹 등록 (정책에 따라 생략) # groupadd oper # groupadd backupdba # groupadd dgdba # groupadd kmdba # groupadd racdba groupadd asmadmin groupadd asmdba groupadd asmoper ### 유저 그룹 설정 변경 (vboxsf는 VirtualBox의 Guest Additions 사용시 설정) usermod -g oinstall -G dba,oper,backupdba,dgdba,kmdba,racdba,asmadmin,asmdba,asmoper,vboxsf oracle # usermod -g oinstall -G dba,oper,backupdba,dgdba,kmdba,racdba,asmadmin,asmdba,asmoper oracle ### 계정 암호 변경 passwd oracle

[root@rac1 ~]# groupadd asmadmin [root@rac1 ~]# groupadd asmdba [root@rac1 ~]# groupadd asmoper [root@rac1 ~]# usermod -g oinstall -G dba,oper,backupdba,dgdba,kmdba,racdba,asmadmin,asmdba,asmoper,vboxsf oracle [root@rac1 ~]# passwd oracle oracle 사용자의 비밀 번호 변경 중 새 암호: 잘못된 암호: 암호는 8 개의 문자 보다 짧습니다 새 암호 재입력: passwd: 모든 인증 토큰이 성공적으로 업데이트 되었습니다.

소프트웨어를 설치할 사용자 계정과 그룹을 생성 또는 추가합니다.

preinstall 패키지가 설치되었다면 oracle 유저와 oinstall, dba, oper, backupdba, dgdba, kmdba, racdba 그룹은 이미 생성되어 있습니다.

vboxsf 그룹은 VirtualBox의 Guest Addition을 사용하기 위한 그룹으로, 실제 운영 환경에서 Guest Addition을 사용하지 않는다면 추가하지 않습니다.

passwd 명령어로 각 계정의 암호를 지정해주면 됩니다.

K) 설치 경로 생성

mkdir -p /u01/app/oracle chown -R oracle:oinstall /u01 chmod -R 775 /u01

[root@rac1 ~]# mkdir -p /u01/app/oracle [root@rac1 ~]# chown -R oracle:oinstall /u01 [root@rac1 ~]# chmod -R 775 /u01

오라클 소프트웨어 설치를 위한 경로를 생성하고, 해당 경로에 대한 권한과 소유권을 수정합니다.

L) 사용자 환경 설정

export TMP=/tmp export TMPDIR=$TMP export EDITOR=vi export ORACLE_HOSTNAME=rac1 # 호스트명에 맞게 변경 export ORACLE_UNQNAME=racdb export ORACLE_BASE=/u01/app/oracle export GRID_HOME=/u01/app/11g/grid export DB_HOME=$ORACLE_BASE/product/11g/db_1 export ORACLE_HOME=$DB_HOME export ORACLE_SID=racdb1 # 2번 노드 racdb2 export ORACLE_TERM=xterm export BASE_PATH=/usr/sbin:$PATH export PATH=$ORACLE_HOME/bin:$ORACLE_HOME/OPatch:$GRID_HOME/bin:$BASE_PATH export LD_LIBRARY_PATH=$ORACLE_HOME/lib:/lib:/usr/lib export CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib export NLS_LANG=AMERICAN_KOREA.AL32UTF8 PS1='[$ORACLE_SID:$PWD]> '

oracle 유저의 .bash_profile을 수정합니다.

root 계정에서 파일을 직접 수정할 수 있습니다.

alias grid_env='export ORACLE_HOME=$GRID_HOME;export ORACLE_SID=+ASM1;export PATH=$ORACLE_HOME/bin:$ORACLE_HOME/OPatch:$BASE_PATH' alias db_env='export ORACLE_HOME=$DB_HOME;export ORACLE_SID=racdb1;export PATH=$ORACLE_HOME/bin:$ORACLE_HOME/OPatch:$BASE_PATH'

Grid와 DB 인스턴스 간의 변환을 쉽게 하기 위해 alias를 설정합니다.

export ORACLE_BASE=/u01/app/oracle export GRID_HOME=/u01/app/11g/grid export DB_HOME=$ORACLE_BASE/product/11g/db_1 export PATH=$PATH:$GRID_HOME/bin

작업의 편의를 위해 root 계정의 .bash_profile에도 경로 정보를 추가로 입력합니다.

{}

V. 공유 환경 및 2번 노드 구성

1. 공유 스토리지 구성

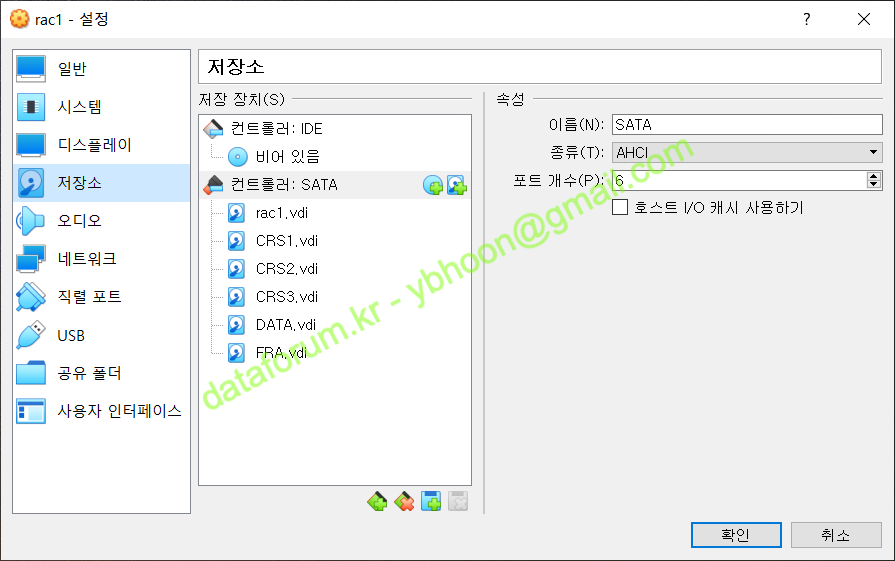

공유 스토리지 구성을 위해 고정 공간이 할당된 가상 디스크 6개를 추가로 생성합니다.

| 파일 이름 | 용량 | 타입 | 용도 | 비고 |

|---|---|---|---|---|

CRS1.vdi | 1GB | Fixed / Shareable | CRS 저장 영역 | 공유(shareable) 디스크로 사용하기 위해서 Fixed Size로 생성합니다. |

| CRS2.vdi | 1GB | Fixed / Shareable | ||

| CRS3.vdi | 1GB | Fixed / Shareable | ||

| DATA.vdi | 30GB | Fixed / Shareable | Data 저장 영역 | |

| FRA.vdi | 20GB | Fixed / Shareable | Fast Recovery Area |

A) 가상 스토리지 파일 생성

vboxmanage createmedium --filename CRS1.vdi --size 1024 --format VDI --variant Fixed vboxmanage createmedium --filename CRS2.vdi --size 1024 --format VDI --variant Fixed vboxmanage createmedium --filename CRS3.vdi --size 1024 --format VDI --variant Fixed vboxmanage createmedium --filename DATA.vdi --size 30720 --format VDI --variant Fixed vboxmanage createmedium --filename FRA.vdi --size 20480 --format VDI --variant Fixed

PS D:\VM> pwd Path ---- D:\VM PS D:\VM> vboxmanage createmedium --filename CRS1.vdi --size 1024 --format VDI --variant Fixed 0%...10%...20%...30%...40%...50%...60%...70%...80%...90%...100% Medium created. UUID: 3a6327e8-0367-4edc-bb5b-591efe123e8d PS D:\VM> vboxmanage createmedium --filename CRS2.vdi --size 1024 --format VDI --variant Fixed 0%...10%...20%...30%...40%...50%...60%...70%...80%...90%...100% Medium created. UUID: 9d4524a2-5a06-478a-b733-81cd9889e59e PS D:\VM> vboxmanage createmedium --filename CRS3.vdi --size 1024 --format VDI --variant Fixed 0%...10%...20%...30%...40%...50%...60%...70%...80%...90%...100% Medium created. UUID: a9d5a021-b91a-4c43-b7d5-2136bf447e83 PS D:\VM> vboxmanage createmedium --filename DATA.vdi --size 30720 --format VDI --variant Fixed 0%...10%...20%...30%...40%...50%...60%...70%...80%...90%...100% Medium created. UUID: 94a0fac2-2040-42ec-9b7e-2fecc49bcf05 PS D:\VM> vboxmanage createmedium --filename FRA.vdi --size 20480 --format VDI --variant Fixed 0%...10%...20%...30%...40%...50%...60%...70%...80%...90%...100% Medium created. UUID: 8f120938-511d-42b1-b15b-dfd4e20218e9

Host 컴퓨터에서 VM에 연결시킬 CRS, MGMT, DATA와 FRA 디스크를 생성합니다.

디스크는 2개의 노드에서 공유할 것이므로, 반드시 Fixed 모드로 디스크 공간이 사전에 할당되도록 생성해야 합니다.

B) 스토리지 파일 공유 설정

vboxmanage modifymedium CRS1.vdi --type shareable vboxmanage modifymedium CRS2.vdi --type shareable vboxmanage modifymedium CRS3.vdi --type shareable vboxmanage modifymedium DATA.vdi --type shareable vboxmanage modifymedium FRA.vdi --type shareable

PS D:\VM> vboxmanage modifymedium CRS1.vdi --type shareable PS D:\VM> vboxmanage modifymedium CRS2.vdi --type shareable PS D:\VM> vboxmanage modifymedium CRS3.vdi --type shareable PS D:\VM> vboxmanage modifymedium DATA.vdi --type shareable PS D:\VM> vboxmanage modifymedium FRA.vdi --type shareable

생성된 디스크들은 모두 shareable 디스크로 속성 변경이 필요합니다.

VirtualBox의 GUI 툴을 사용하여 변경할 수도 있습니다.

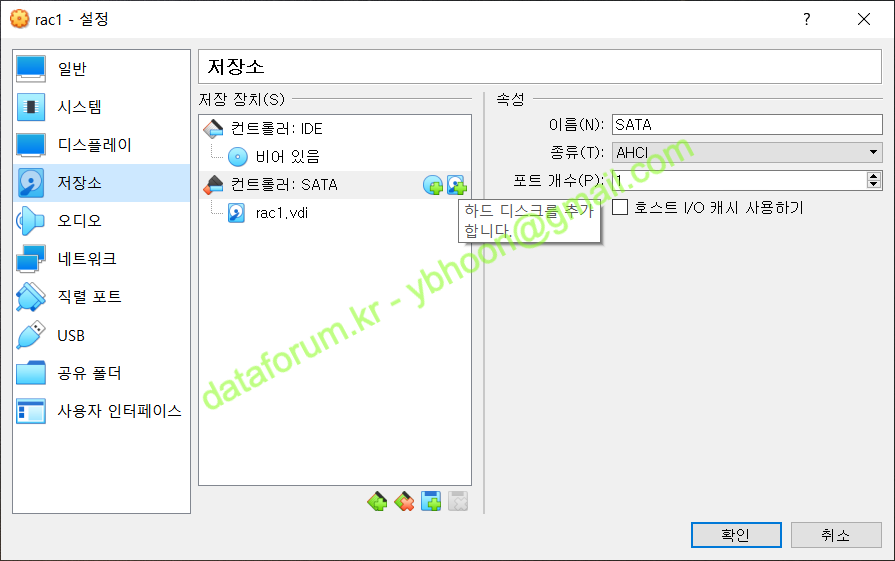

C) VM에 스토리지 연결

정지된 1번 노드의 설정 모드로 들어가서 디스크 파일을 추가합니다.

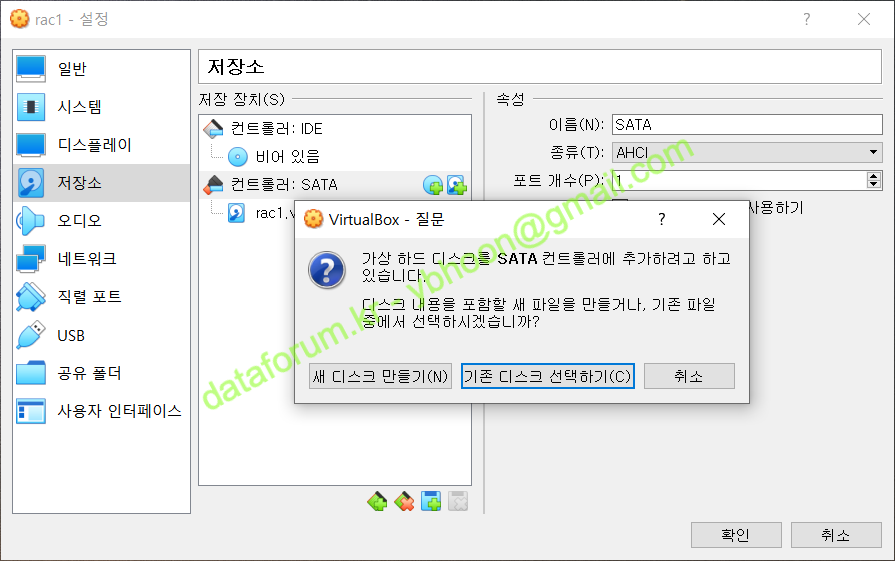

SATA 콘트롤러의 오른쪽에 하드디스크 모양의 아이콘을 클릭합니다

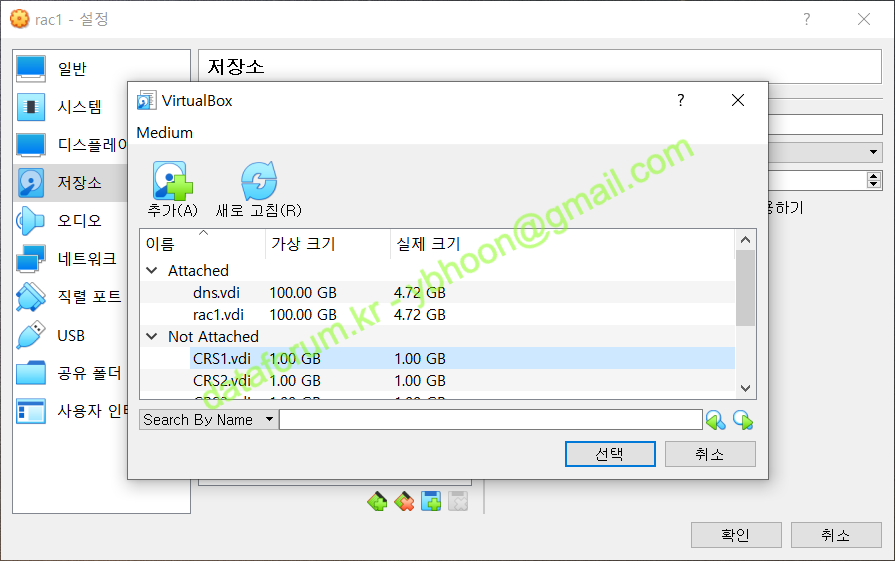

vboxmanage 명령으로 이미 생성된 디스크 파일을 추가할 것이므로 <기존 디스크 선택하기>를 클릭합니다.

Not Attatched에 등록된 디스크 목록에서 "CRS1.vdi"를 선택한 후 <선택>을 클릭합니다.

만약 생성된 디스크 이미지가 목록에 없다면 <추가> 아이콘을 클릭한 후에 디스크 이미지를 찾아서 추가하면 됩니다.

정상적으로 스토리지가 추가된 것을 확인할 수 있습니다.

다른 공유 디스크들도 같은 방법으로 추가해줍니다.

나머지 디스크 파일 모두 순서에 맞게 SATA 컨트롤러에 등록시켜줍니다.

반드시 동일한 순서대로 다른 노드에도 등록시켜야 합니다.

2. ASM 환경 구성

A) ASM 환경 설정 및 초기화

oracleasm configure -i oracleasm init oracleasm status oracleasm configure

[root@rac1 ~]# oracleasm configure -i

Configuring the Oracle ASM library driver.

This will configure the on-boot properties of the Oracle ASM library

driver. The following questions will determine whether the driver is

loaded on boot and what permissions it will have. The current values

will be shown in brackets ('[]'). Hitting <ENTER> without typing an

answer will keep that current value. Ctrl-C will abort.

Default user to own the driver interface []: oracle

Default group to own the driver interface []: asmadmin

Start Oracle ASM library driver on boot (y/n) [n]: y

Scan for Oracle ASM disks on boot (y/n) [y]:

Writing Oracle ASM library driver configuration: done

[root@rac1 ~]# oracleasm init

Creating /dev/oracleasm mount point: /dev/oracleasm

Loading module "oracleasm": oracleasm

Configuring "oracleasm" to use device physical block size

Mounting ASMlib driver filesystem: /dev/oracleasm

[root@rac1 ~]# oracleasm status

Checking if ASM is loaded: yes

Checking if /dev/oracleasm is mounted: yes

[root@rac1 ~]# oracleasm configure

ORACLEASM_ENABLED=true

ORACLEASM_UID=oracle

ORACLEASM_GID=asmadmin

ORACLEASM_SCANBOOT=true

ORACLEASM_SCANORDER=""

ORACLEASM_SCANEXCLUDE=""

ORACLEASM_SCAN_DIRECTORIES=""

ORACLEASM_USE_LOGICAL_BLOCK_SIZE="false"

ASM library에 대한 추가적인 환경 설정(사용자, 그룹, 부팅시 활성화, 부팅시 스캔 여부)을 수행하고 적용 여부를 검증합니다.

B) 디스크 파티셔닝

ls /dev/sd* fdisk /dev/sdb ### "n", "p", "1", "엔터", "엔터", "w" 입력 fdisk /dev/sdc ### "n", "p", "1", "엔터", "엔터", "w" 입력 fdisk /dev/sdd ### "n", "p", "1", "엔터", "엔터", "w" 입력 fdisk /dev/sde ### "n", "p", "1", "엔터", "엔터", "w" 입력 fdisk /dev/sdf ### "n", "p", "1", "엔터", "엔터", "w" 입력 ls /dev/sd*

[root@rac1 ~]# ls /dev/sd*

/dev/sda /dev/sda2 /dev/sdc /dev/sde

/dev/sda1 /dev/sdb /dev/sdd /dev/sdf

[root@rac1 ~]# fdisk /dev/sdb

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table

Building a new DOS disklabel with disk identifier 0xaf5d0328.

Command (m for help): n

Partition type:

p primary (0 primary, 0 extended, 4 free)

e extended

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-2097151, default 2048):

Using default value 2048

Last sector, +sectors or +size{K,M,G} (2048-2097151, default 2097151):

Using default value 2097151

Partition 1 of type Linux and of size 1023 MiB is set

Command (m for help): w

The partition table has been altered!

Calling ioctl() to re-read partition table.

Syncing disks.

[root@rac1 ~]# fdisk /dev/sdc

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table

Building a new DOS disklabel with disk identifier 0x16fccdd3.

Command (m for help): n

Partition type:

p primary (0 primary, 0 extended, 4 free)

e extended

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-2097151, default 2048):

Using default value 2048

Last sector, +sectors or +size{K,M,G} (2048-2097151, default 2097151):

Using default value 2097151

Partition 1 of type Linux and of size 1023 MiB is set

Command (m for help): w

The partition table has been altered!

Calling ioctl() to re-read partition table.

Syncing disks.

[root@rac1 ~]# fdisk /dev/sdd

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table

Building a new DOS disklabel with disk identifier 0x6072c319.

Command (m for help): n

Partition type:

p primary (0 primary, 0 extended, 4 free)

e extended

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-2097151, default 2048):

Using default value 2048

Last sector, +sectors or +size{K,M,G} (2048-2097151, default 2097151):

Using default value 2097151

Partition 1 of type Linux and of size 1023 MiB is set

Command (m for help): w

The partition table has been altered!

Calling ioctl() to re-read partition table.

Syncing disks.

[root@rac1 ~]# fdisk /dev/sde

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table

Building a new DOS disklabel with disk identifier 0x30096059.

Command (m for help): n

Partition type:

p primary (0 primary, 0 extended, 4 free)

e extended

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-62914559, default 2048):

Using default value 2048

Last sector, +sectors or +size{K,M,G} (2048-62914559, default 62914559):

Using default value 62914559

Partition 1 of type Linux and of size 30 GiB is set

Command (m for help): w

The partition table has been altered!

Calling ioctl() to re-read partition table.

Syncing disks.

[root@rac1 ~]# fdisk /dev/sdg

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table

Building a new DOS disklabel with disk identifier 0x7dd5a9bc.

Command (m for help): n

Partition type:

p primary (0 primary, 0 extended, 4 free)

e extended

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-41943039, default 2048):

Using default value 2048

Last sector, +sectors or +size{K,M,G} (2048-41943039, default 41943039):

Using default value 41943039

Partition 1 of type Linux and of size 20 GiB is set

Command (m for help): w

The partition table has been altered!

Calling ioctl() to re-read partition table.

Syncing disks.

[root@rac1 ~]# ls /dev/sd*

/dev/sda /dev/sda2 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 /dev/sdf1

/dev/sda1 /dev/sdb /dev/sdc /dev/sdd /dev/sde /dev/sdf

VM에 연결된 디스크에 fdisk 명령어로 파티션 분할 작업을 수행 합니다.

실습의 편의를 위해 하나의 디스크가 하나의 파티션이 되도록 합니다.

C) ASM 디스크 생성

oracleasm createdisk CRS1 /dev/sdb1 oracleasm createdisk CRS2 /dev/sdc1 oracleasm createdisk CRS3 /dev/sdd1 oracleasm createdisk DATA /dev/sde1 oracleasm createdisk FRA /dev/sdf1 oracleasm scandisks oracleasm listdisks

[root@rac1 ~]# oracleasm createdisk CRS1 /dev/sdb1 Writing disk header: done Instantiating disk: done [root@rac1 ~]# oracleasm createdisk CRS2 /dev/sdc1 Writing disk header: done Instantiating disk: done [root@rac1 ~]# oracleasm createdisk CRS3 /dev/sdd1 Writing disk header: done Instantiating disk: done [root@rac1 ~]# oracleasm createdisk DATA /dev/sde1 Writing disk header: done Instantiating disk: done [root@rac1 ~]# oracleasm createdisk FRA /dev/sdf1 Writing disk header: done Instantiating disk: done [root@rac1 ~]# oracleasm scandisks Reloading disk partitions: done Cleaning any stale ASM disks... Scanning system for ASM disks... [root@rac1 ~]# oracleasm listdisks CRS1 CRS2 CRS3 DATA FRA

VM에 마운트된 디스크를 각각 ASM Disk로 할당해줍니다.

순서대로 마운트가 되었다면, 디바이스 명의 알파벳 순으로 ASM 디스크를 생성하면 됩니다.

{}

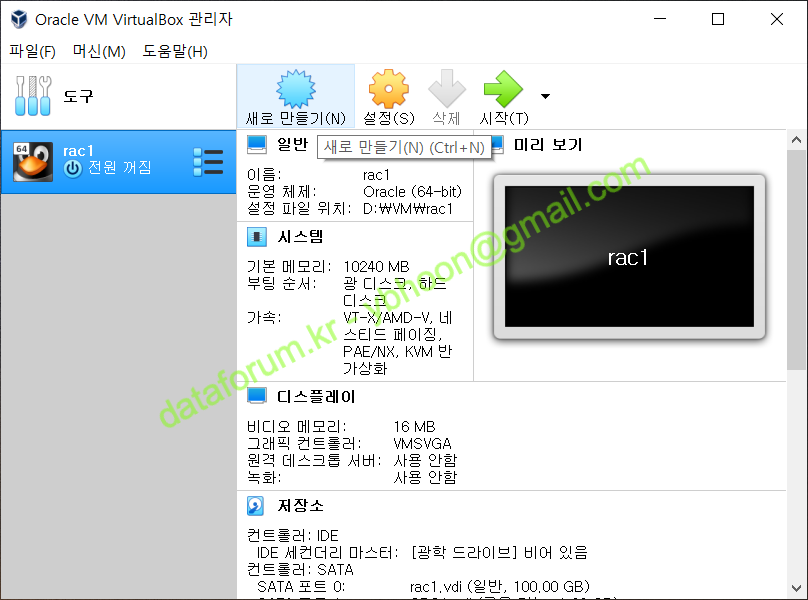

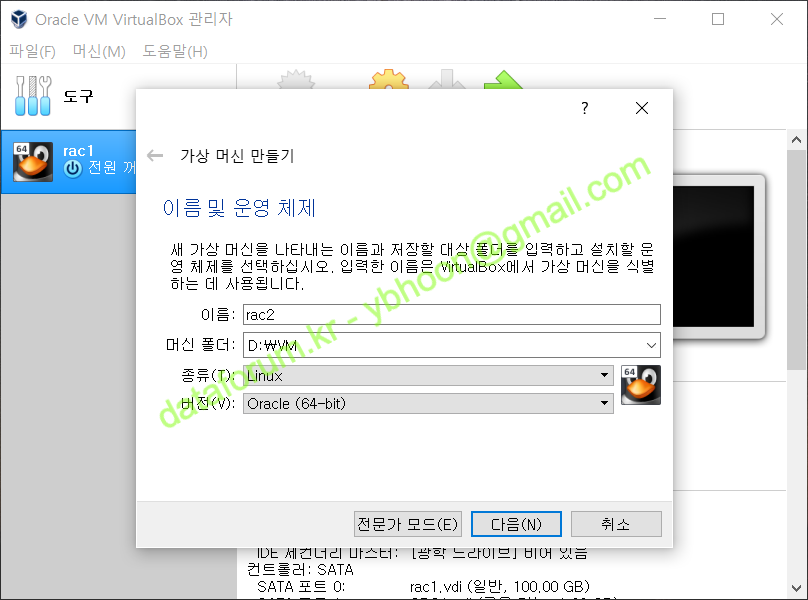

3. 2번 노드 구성

A) 2번 노드 가상 머신 만들기

.

.

가상 머신 2번 노드를 만들기 위해 VirtualBox에서 ‘새로 만들기’를 클릭합니다.

가상 머신의 이름을 "rac2"로 정하고, 1번 노드와 동일한 경로를 머신 폴더로 지정합니다.

해당 디렉토리 아래에 rac2라는 디렉토리가 생성되고, 디렉토리 안에 가상 머신 관련 파일들이 저장됩니다.

OS의 종류는 'Linux'로 하고 설치될 버전은 'Oracle (64-bit)'를 선택한 후 <다음>을 클릭합니다.

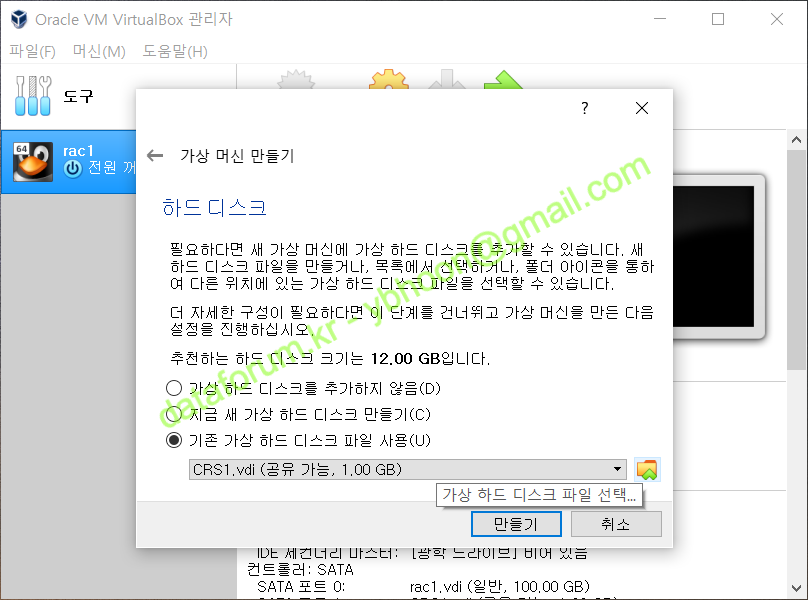

메모리 크기는 1번 노드와 동일하게 10240MB로 선택한 후 <다음>을 클릭합니다.

B) 1번 노드 VM 복제

vboxmanage clonemedium disk .\rac1.vdi ..\rac2\rac2.vdi

PS D:\VM\rac1> vboxmanage clonemedium disk .\rac1.vdi ..\rac2\rac2.vdi 0%...10%...20%...30%...40%...50%...60%...70%...80%...90%...100% Clone medium created in format 'VDI'. UUID: 28c8742c-e783-4dca-b95c-5919bfd1257e

1번 노드가 정지된 상태에서 1번 노드의 복제본을 rac2 디렉토리에 저장합니다.

1번 노드의 UUID값과 다른 이미지가 생성되도록 반드시 VirtualBox에서 제공하는 방식으로 복제합니다.

하드 디스크는 '기존의 가상 하드 디스크 파일 사용'을 선택합니다.

그리고 방금 복제한 가상 하드 디스크 파일을 선택하기 위해 폴더 모양의 아이콘을 클릭합니다.

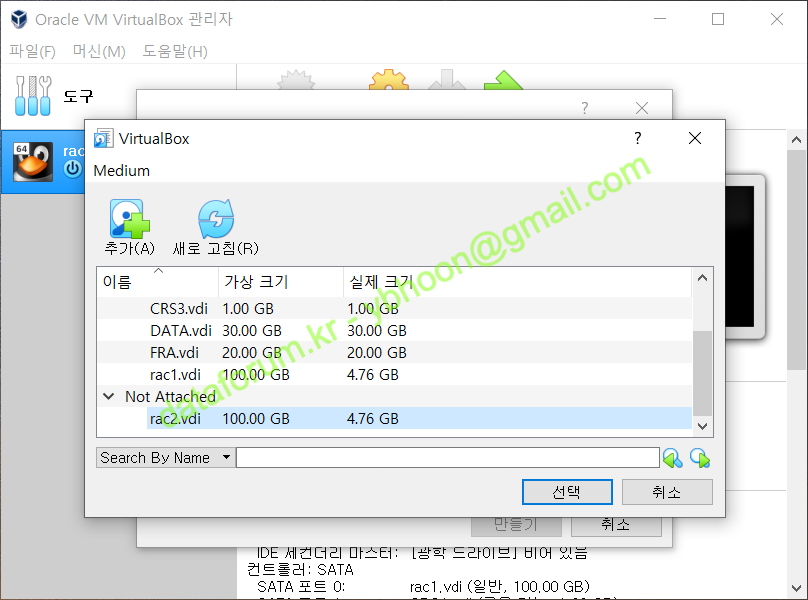

vboxmanage 명령으로 디스크를 복제했다면, Not Attatched 항목에 rac2.vdi 파일이 존재합니다.

만약 목록에 없다면 <추가> 버튼을 클릭하여 복제한 이미지를 찾아 불러오면 됩니다.

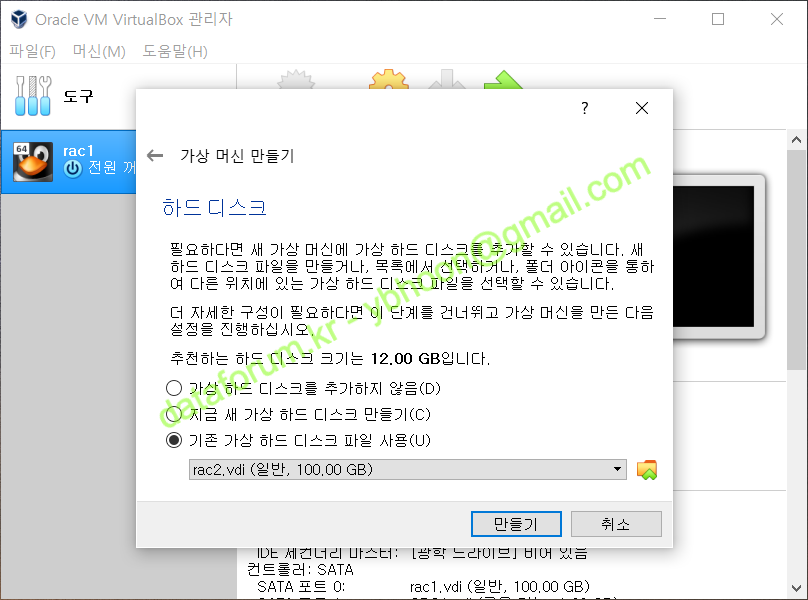

rac2.vdi 파일을 선택한 후 <선택> 버튼을 클릭합니다.

<만들기>를 클릭하면, 지금까지 선택한 환경에 맞게 가상 머신이 생성됩니다.

C) 2번 노드 VM 환경 설정

기본적으로 생성된 가상 머신을 RAC 환경에 맞게 변경해야 하므로, 2번 노드를 선택하고 <설정>을 클릭합니다.

부팅 순서에서 플로피 디스크를 해제합니다.

1번 노드와 동일한 순서로 공유 디스크를 추가시켜 줍니다.

반드시 같은 순서대로 SATA 컨트롤러에 연결시켜야 합니다.

오디오는 사용하지 않을 것이므로 '오디오 사용하기'를 해제합니다.

어댑터 1의 네트워크 설정을 1번 노드와 동일하게 구성합니다.

본인이 사용할 네트워크 환경에 맞게 설정하면 됩니다.

RAC 노드간의 통신을 위해 어댑터 2를 활성화시킵니다.

어댑터 2번 항목에 가서 '네트워크 어댑터 사용하기'를 체크하고, 1번 노드와 동일하게 '호스트 전용 어댑터'로 구성합니다.

1번 노드와 동일하게 공유 폴더 기능을 설정합니다.

공유 폴더를 설정할 경우, 호스트 서버에 저장된 설치 파일을 업로드 없이 바로 사용할 수 있습니다.

모든 구성이 완료되었으면 <확인>을 클릭해서 변경한 설정 값을 저장하고, 가상머신을 기동합니다.

D) 네트워크 설정 변경

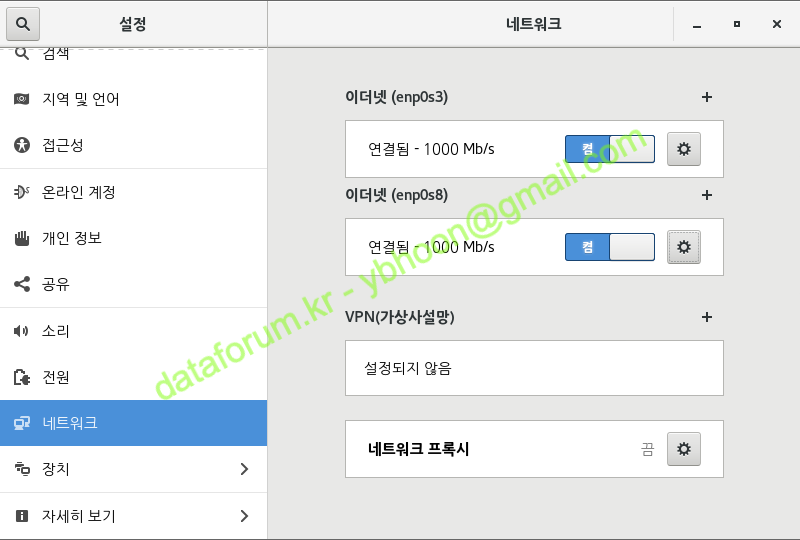

네트워크 설정을 변경하기 위해 root 계정으로 접속한 후에 '프로그램' > '시스템 도구' > '설정'을 클릭합니다.

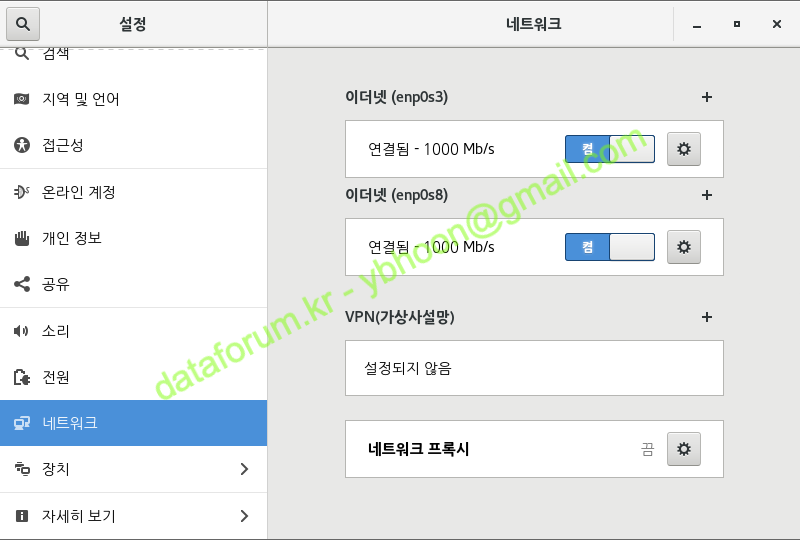

네트워크 항목으로 이동한 후에 각 이더넷 항목에 톱니바퀴 모양의 아이콘을 클릭하여 설정을 변경합니다.

참고로 VirtualBox를 기준으로 했을 떄, 이더넷 enp0s3은 Public 네트워크이고 enp0s8은 Private 네트워크의 인터페이스입니다.

ip link set <old NIC alias> down ip link set <old NIC alias> name <new NIC alias> ip link set <new NIC alias> up mv /etc/sysconfig/network-scripts/ifcfg-<old NIC alias> /etc/sysconfig/network-scripts/ifcfg-<new NIC alias> sed -ire "s/NAME=\"<old NIC alias>\"/NAME=\"<new NIC alias>\"/" /etc/sysconfig/network-scripts/ifcfg-<new NIC alias> sed -ire "s/DEVICE=\"<old NIC alias>\"/NAME=\"<new NIC alias>\"/" /etc/sysconfig/network-scripts/ifcfg-<new NIC alias>

만약 2번 VM의 NIC(Network Interface Card)의 alias가 1번 노드의 alias와 일치하지 않을 경우, grid 검증 과정에서 오류가 발생합니다.

좌측의 명령어로 alias를 1번과 동일하게 변경하여 해결할 수 있습니다.

추가적으로 NIC별 UUID 확인이 필요할 경우 다음의 명령어를 사용합니다.

nmcli connection

이더넷 enp0s3의 IPv4 항목에서 주소를 "10.0.1.102"(2번 노드의 Public 네트워크 IP)로 변경한 후 <적용>을 클릭합니다.

리눅스 버전에 따라 네트워크 정보가 초기화되어 있을 수 있습니다.

그럴 때는 아래의 정보와 같이 입력합니다.

항목 | 입력값 | 비고 |

|---|---|---|

| 주소 | 10.0.1.102 | 1번 노드 Public IP 주소 |

| 네트마스크 | 24 | 서브넷 마스크 값으로 255.255.255.0 사용 가능 |

| 게이트웨이 | 10.0.1.1 | Public 망의 게이트웨이 |

| 네임서버(DNS) | 127.0.0.1 | dnsmasq를 사용할 경우 loopback IP 사용 |

| 검색 도메인 | localdomain | 로컬 도메인 정보 입력 |

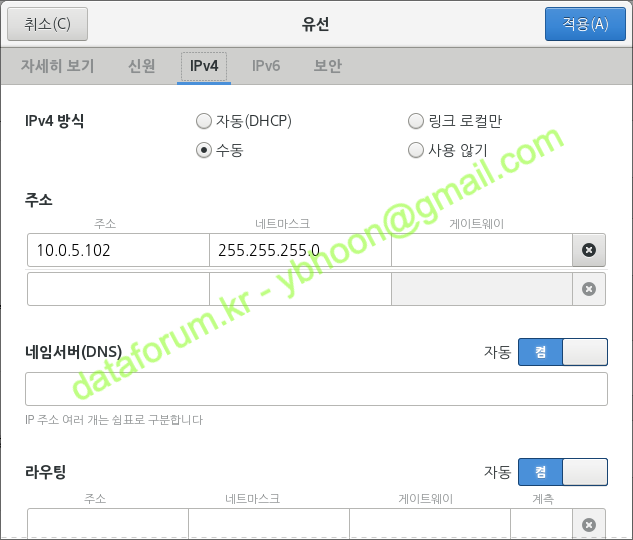

이더넷 enp0s8의 IPv4 항목에서 주소를 "10.0.5.102"(2번 노드의 Private 네트워크 IP)로 변경한 후 <적용>을 클릭합니다.

마찬가지로 네트워크 정보가 초기화 되었을 경우, 아래와 같이 입력합니다.

항목 | 입력값 | 비고 |

|---|---|---|

| 주소 | 10.0.5.101 | 1번 노드 Private IP 주소 |

| 네트마스크 | 24 | 서브넷 마스크 값으로 255.255.255.0 사용 가능 |

각 이더넷 인터페이스를 껏다가 키면 변경된 설정이 적용됩니다.

또는 명령 프롬프트에서 아래 명령을 수행합니다.

systemctl restart network

ip addr show vi /etc/sysconfig/network-scripts/ifcfg-<public 인터페이스명> # IPADDR=XXX.XXX.XXX.XXX 부분 변경 vi /etc/sysconfig/network-scripts/ifcfg-<private 인터페이스명> # IPADDR=XXX.XXX.XXX.XXX 부분 변경 systemctl restart network ip addr show

[root@rac1 ~]# ip addr show

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: enp0s3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 08:00:27:72:b8:d8 brd ff:ff:ff:ff:ff:ff

inet 10.0.1.101/24 brd 10.0.1.255 scope global noprefixroute enp0s3

valid_lft forever preferred_lft forever

inet6 fe80::a00:27ff:fe72:b8d8/64 scope link

valid_lft forever preferred_lft forever

3: enp0s8: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 08:00:27:fd:6d:a9 brd ff:ff:ff:ff:ff:ff

inet 10.0.5.101/24 brd 10.0.5.255 scope global noprefixroute enp0s8

valid_lft forever preferred_lft forever

inet6 fe80::cd39:da9a:86ab:40a8/64 scope link noprefixroute

valid_lft forever preferred_lft forever

[root@rac1 ~]# vi /etc/sysconfig/network-scripts/ifcfg-enp0s3

... << 생략 >> ...

IPADDR=10.0.1.102

... << 생략 >> ...

[root@rac1 ~]# vi /etc/sysconfig/network-scripts/ifcfg-enp0s8

... << 생략 >> ...

IPADDR=10.0.5.102

... << 생략 >> ...

[root@rac1 ~]# systemctl restart network

[root@rac1 ~]# ip addr show

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: enp0s3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 08:00:27:72:b8:d8 brd ff:ff:ff:ff:ff:ff

inet 10.0.1.102/24 brd 10.0.1.255 scope global noprefixroute enp0s3

valid_lft forever preferred_lft forever

inet6 fe80::a00:27ff:fe72:b8d8/64 scope link

valid_lft forever preferred_lft forever

3: enp0s8: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 08:00:27:fd:6d:a9 brd ff:ff:ff:ff:ff:ff

inet 10.0.5.102/24 brd 10.0.5.255 scope global noprefixroute enp0s8

valid_lft forever preferred_lft forever

inet6 fe80::cd39:da9a:86ab:40a8/64 scope link noprefixroute

valid_lft forever preferred_lft forever

위의 GUI 방식보다 간단하게 CLI 모드에서 vi 편집기를 사용하여 IP를 수정할 수도 있습니다.

다만 Public과 Private 이더넷을 혼동하여 잘못 설정할 수 있으므로 주의가 필요합니다.

E) 호스트명 변경

hostnamectl status hostnamectl set-hostname rac2 hostnamectl status

[root@rac1 ~]# hostnamectl status

Static hostname: rac1

Icon name: computer-vm

Chassis: vm

Machine ID: 5554cd8ab5124283be4afd144783a884

Boot ID: dc642dbe4f44426f82469fbda8e61f27

Virtualization: kvm

Operating System: Oracle Linux Server 7.6

CPE OS Name: cpe:/o:oracle:linux:7:6:server

Kernel: Linux 4.14.35-1818.3.3.el7uek.x86_64

Architecture: x86-64

[root@rac1 ~]# hostnamectl set-hostname rac2

[root@rac1 ~]# hostnamectl status

Static hostname: rac2

Icon name: computer-vm

Chassis: vm

Machine ID: 5554cd8ab5124283be4afd144783a884

Boot ID: dc642dbe4f44426f82469fbda8e61f27

Virtualization: kvm

Operating System: Oracle Linux Server 7.6

CPE OS Name: cpe:/o:oracle:linux:7:6:server

Kernel: Linux 4.14.35-1818.3.3.el7uek.x86_64

Architecture: x86-64

2번 노드의 호스트 명은 CLI 모드에서 간단한 명령어로 변경할 수 있습니다.

systemctl set-default multi-user.target

[root@rac2 ~]# systemctl set-default multi-user.target Removed symlink /etc/systemd/system/default.target. Created symlink from /etc/systemd/system/default.target to /usr/lib/systemd/system/multi-user.target.

설치 과정 중에 리소스를 절약하기 위해 2번 노드는 텍스트 모드로 실행되도록 수정합니다.

{}

F) 사용자 환경 변수 변경

export ORACLE_HOSTNAME=rac2 export ORACLE_SID=racdb2

[root@rac2 ~]# cat ~oracle/.bash_profile

# .bash_profile

# Get the aliases and functions

if [ -f ~/.bashrc ]; then

. ~/.bashrc

fi

# User specific environment and startup programs

PATH=$PATH:$HOME/.local/bin:$HOME/bin

export PATH

export TMP=/tmp

export TMPDIR=$TMP

export EDITOR=vi

export ORACLE_HOSTNAME=rac2 # 호스트명에 맞게 변경

export ORACLE_UNQNAME=racdb

export ORACLE_BASE=/u01/app/oracle

export GRID_HOME=/u01/app/11g/grid

export DB_HOME=$ORACLE_BASE/product/11g/db_1

export ORACLE_HOME=$DB_HOME

export ORACLE_SID=racdb2 # 2번 노드 racdb2

export ORACLE_TERM=xterm

export BASE_PATH=/usr/sbin:$PATH

export PATH=$ORACLE_HOME/bin:$ORACLE_HOME/OPatch:$GRID_HOME/bin:$BASE_PATH

export LD_LIBRARY_PATH=$ORACLE_HOME/lib:/lib:/usr/lib

export CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib

export NLS_LANG=AMERICAN_KOREA.AL32UTF8

PS1='[$ORACLE_SID:$PWD]> '

oracle 유저의 환경 설정을 2번 노드에 맞게 수정합니다.

alias grid_env='export ORACLE_HOME=$GRID_HOME;export ORACLE_SID=+ASM2;export PATH=$ORACLE_HOME/bin:$ORACLE_HOME/OPatch:$BASE_PATH' alias db_env='export ORACLE_HOME=$DB_HOME;export ORACLE_SID=racdb2;export PATH=$ORACLE_HOME/bin:$ORACLE_HOME/OPatch:$BASE_PATH'

aslias 설정의 ORACLE_SID 정보도 2번 노드에 맞게 수정합니다.

{}

VI. 11g Grid Infrastructure 설치

1. Grid 설치

A) 환경 설정 및 OUI 실행

# grid_env export LANG=C cd <Grid 설치 파일 압축 디렉토리> ./runInstaller

Linux 7 에서는 11g의 OUI에서 한글이 표기가 되지 않으므로 LANG=C 설정으로 언어 표기를 초기화한 후 OUI를 실행합니다.

‘Skip software updates’를 선택하고 <Next>를 클릭합니다.

‘Install and Configure Oracle Grid Infrastructure for a Cluster’를 선택하고 <Next>를 클릭합니다.

‘Advanced Installation’을 선택하고 <Next>를 클릭합니다.

언어에 ‘Korean’을 추가하고 <Next>를 클릭합니다

Cluster Name에 “rac”, SCAN Name에 “rac-scan”, SCAN Port에 “1521”을 입력합니다.

Configure GNS를 해제하고 <Next>를 클릭합니다

<Add> 버튼을 클릭하여 RAC2 노드에 대한 정보를 추가합니다.

Public Hostname에 ‘rac2’ 와 Virtual Hostname에 ‘rac2-vip’를 입력하고 <OK>를 클릭합니다.

SSH 구성을 위해 <SSH Connecivity>를 클릭합니다.

OS Password에 oracle 유저의 암호(“oracle”)를 입력하고 <Setup>을 클릭합니다

SSH 설정이 완료되었으면 <OK>를 클릭합니다

설치를 진행하기 위해 <Next>를 클릭합니다.

enp0s3은 ‘Public’, enp0s8은 ‘Private’로 선택되었는지 체크하고 <Next>를 클릭합니다

ASM에 데이터베이스를 구성할 것이므로 ‘Oracle Automatic Storage Management (Oracle ASM)’을 선택하고 <Next>를 클릭합니다.

먼저 클러스터 환경을 구성하고 저장할 디스크 그룹을 생성합니다.

디스크 그룹 이름에 ‘CRS'를 입력하고 ‘ORCL:CRS1’부터 ‘ORCL:CRS3’까지 선택하고 <Next>를 클릭합니다.

Redundancy는 ‘Normal’을 유지하고 AU Size는 기본값(1MB)으로 둡니다.

'Use same passwords for these accounts’를 선택하고 암호에 ‘oracle_4U’를 입력한 후 <Next>를 클릭합니다

‘Do not use Intelligent Platform Management Interface(IPMI)’ 선택 후 <Next>를 클릭합니다

ASM 관련 그룹이 제대로 선택되어 있는지 확인하고 <Next>를 클릭합니다.

Oracle Base가 “/u01/app/oracle”, Software Location이 “/u01/app/11g/grid”로 되어 있는지 확인하고 <Next>를 클릭합니다.

Inventory Directory가 "/u01/app/oraInventory"로 되어 있는지 확인하고 <Next>를 클릭합니다

오라클 설치에 필요한 조건 검사가 진행됩니다.

패키지 관련 2가지 waring이 있습니다. 이중에 cvuqdisk 패키지는 <Fix & Check Again>에서 수정이 가능합니다.

<Fix & Check Again>을 클릭하면 root 유저로 스크립트를 실행할 수 있는 안내창이 나옵니다.

B) runfixup 쉘 실행

/tmp/CVU_11.2.0.4.0_oracle/runfixup.sh

[root@rac1 ~]# /tmp/CVU_11.2.0.4.0_oracle/runfixup.sh Response file being used is :/tmp/CVU_11.2.0.4.0_oracle/fixup.response Enable file being used is :/tmp/CVU_11.2.0.4.0_oracle/fixup.enable Log file location: /tmp/CVU_11.2.0.4.0_oracle/orarun.log Installing Package /tmp/CVU_11.2.0.4.0_oracle//cvuqdisk-1.0.9-1.rpm 준비 중... ################################# [100%] Updating / installing... 1:cvuqdisk-1.0.9-1 ################################# [100%]

[root@rac2 ~]# /tmp/CVU_11.2.0.4.0_oracle/runfixup.sh Response file being used is :/tmp/CVU_11.2.0.4.0_oracle/fixup.response Enable file being used is :/tmp/CVU_11.2.0.4.0_oracle/fixup.enable Log file location: /tmp/CVU_11.2.0.4.0_oracle/orarun.log Installing Package /tmp/CVU_11.2.0.4.0_oracle//cvuqdisk-1.0.9-1.rpm 준비 중... ################################# [100%] Updating / installing... 1:cvuqdisk-1.0.9-1 ################################# [100%]

안내 창에서 가이드 된 스크립트를 root 유저 권한으로 모든 노드에서 수행합니다.

그리고 다시 OUI 화면으로 돌아와 <OK>를 클릭하면 재검사가 수행됩니다.

남아있는 pdksh 패키지는 리눅스 7에서는 더이상 제공되지 않으며, 오라클(문서 1962046.1)로부터 무시해도 되는 패키지임을 확인 받았으므로 'Ignore All'을 체크하고 <Next>를 클릭합니다.

해당 패키지를 무시하는 것과 관련하여 안내 창이 뜨면 <Yes>를 클릭합니다.

설치 내역에 대한 요약 정보를 확인할 수 있습니다.

수정할 부분이 없으면 <Install>을 클릭합니다.

Grid Infrastructure 설치가 진행됩니다

구성 스크립트를 실행하라는 창이 뜹니다.

스크립트를 실행하기에 앞서 먼저 1837001 패치를 수행해야 합니다.

해당 패치를 수행하지 않고 구성 스크립트를 실행할 경우, 클러스터 구성 과정 중에 에러가 발생하며 작업이 진행되지 않습니다.

따라서 반드시 해당 패치를 스크립트 수행 전에 적용해야 합니다. (최소 두 번째 스크립트 수행 전)

C) Grid 18370031 패치

export ORACLE_BASE=/u01/app/oracle export GRID_HOME=/u01/app/11g/grid $GRID_HOME/OPatch/opatch version mv $GRID_HOME/OPatch $GRID_HOME/OPatch.old unzip <패치 파일 다운로드 디렉토리>/p6880880_112000_Linux-x86-64.zip -d $GRID_HOME chown -R oracle:oinstall $GRID_HOME/OPatch $GRID_HOME/OPatch/opatch version

[root@rac1 ~]# export ORACLE_BASE=/u01/app/oracle [root@rac1 ~]# export GRID_HOME=/u01/app/11g/grid [root@rac1 ~]# $GRID_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.4 OPatch succeeded. [root@rac1 ~]# mv $GRID_HOME/OPatch $GRID_HOME/OPatch.old [root@rac1 ~]# unzip /media/sf_oracle/11.2/p6880880_112000_Linux-x86-64.zip -d $GRID_HOME/ Archive: /media/sf_oracle/11.2/p6880880_112000_Linux-x86-64.zip ... << 중략 >> ... inflating: /u01/app/11g/grid/OPatch/operr [root@rac1 ~]# chown -R oracle:oinstall $GRID_HOME/OPatch [root@rac1 ~]# $GRID_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.23 OPatch succeeded.

[root@rac2 ~]# export ORACLE_BASE=/u01/app/oracle [root@rac2 ~]# export GRID_HOME=/u01/app/11g/grid [root@rac2 ~]# $GRID_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.4 OPatch succeeded. [root@rac2 ~]# mv $GRID_HOME/OPatch $GRID_HOME/OPatch.old [root@rac2 ~]# unzip /media/sf_oracle/11.2/p6880880_112000_Linux-x86-64.zip -d $GRID_HOME/ Archive: /media/sf_oracle/11.2/p6880880_112000_Linux-x86-64.zip ... << 중략 >> ... inflating: /u01/app/11g/grid/OPatch/operr [root@rac2 ~]# chown -R oracle:oinstall $GRID_HOME/OPatch [root@rac2 ~]# $GRID_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.23 OPatch succeeded.

먼저 패치를 위해 $GRID_HOME의 Opatch 파일을 최신 버전으로 업데이트 합니다.

Grid를 설치할 모든 노드에 업데이트해야 합니다.

grid_env opatch napply -local <패치 압축 해제 디렉토리>/18370031 opatch lspatches

[racdb1:/home/oracle]> grid_env [+ASM1:/home/oracle]> opatch napply -local /media/sf_oracle/11.2/18370031 Oracle Interim 패치 설치 프로그램 버전 11.2.0.3.23 Copyright (c) 2020, Oracle Corporation. All rights reserved. Oracle 홈: /u01/app/11g/grid 중앙 인벤토리: /u01/app/oraInventory 출처: /u01/app/11g/grid/oraInst.loc OPatch 버전: 11.2.0.3.23 OUI 버전: 11.2.0.4.0 로그 파일 위치: /u01/app/11g/grid/cfgtoollogs/opatch/opatch2020-03-28_14-35-25오후_1.log Verifying environment and performing prerequisite checks... OPatch continues with these patches: 18370031 계속하겠습니까? [y|n] y User Responded with: Y All checks passed. 로컬 시스템의 이 ORACLE_HOME에서 실행 중인 Oracle 인스턴스를 종료하십시오. (Oracle 홈 = '/u01/app/11g/grid') 로컬 시스템이 패치할 준비가 되었습니까? [y|n] y User Responded with: Y Backing up files... OH '/u01/app/11g/grid'에 Interim 패치 '18370031'을(를) 적용하는 중 oracle.crs, 11.2.0.4.0 구성요소를 패치하는 중... Patch 18370031 successfully applied. Log file location: /u01/app/11g/grid/cfgtoollogs/opatch/opatch2020-03-28_14-35-25오후_1.log OPatch succeeded. [+ASM1:/home/oracle]> opatch lspatches 18370031;Grid Infrastructure Patch Set Update : 11.2.0.4.x (gibugno) OPatch succeeded.

[racdb2:/home/oracle]> grid_env [+ASM2:/home/oracle]> opatch napply -local /media/sf_oracle/11.2/18370031 Oracle Interim 패치 설치 프로그램 버전 11.2.0.3.23 Copyright (c) 2020, Oracle Corporation. All rights reserved. Oracle 홈: /u01/app/11g/grid 중앙 인벤토리: /u01/app/oraInventory 출처: /u01/app/11g/grid/oraInst.loc OPatch 버전: 11.2.0.3.23 OUI 버전: 11.2.0.4.0 로그 파일 위치: /u01/app/11g/grid/cfgtoollogs/opatch/opatch2020-03-28_14-39-24오후_1.log Verifying environment and performing prerequisite checks... OPatch continues with these patches: 18370031 계속하겠습니까? [y|n] y User Responded with: Y All checks passed. 로컬 시스템의 이 ORACLE_HOME에서 실행 중인 Oracle 인스턴스를 종료하십시오. (Oracle 홈 = '/u01/app/11g/grid') 로컬 시스템이 패치할 준비가 되었습니까? [y|n] y User Responded with: Y Backing up files... OH '/u01/app/11g/grid'에 Interim 패치 '18370031'을(를) 적용하는 중 oracle.crs, 11.2.0.4.0 구성요소를 패치하는 중... Patch 18370031 successfully applied. Log file location: /u01/app/11g/grid/cfgtoollogs/opatch/opatch2020-03-28_14-39-24오후_1.log OPatch succeeded. [+ASM2:/home/oracle]> opatch lspatches 18370031;Grid Infrastructure Patch Set Update : 11.2.0.4.x (gibugno) OPatch succeeded.

업데이트한 Opatch 파일로 18370031 패치를 Grid에 적용합니다.

설치하고자 하는 모든 노드에서 각각 실행해야 합니다.

D) root 스크립트 실행

/u01/app/oraInventory/orainstRoot.sh

[root@rac1 ~]# /u01/app/oraInventory/orainstRoot.sh Changing permissions of /u01/app/oraInventory. Adding read,write permissions for group. Removing read,write,execute permissions for world. Changing groupname of /u01/app/oraInventory to oinstall. The execution of the script is complete.

[root@rac2 ~]# /u01/app/oraInventory/orainstRoot.sh Changing permissions of /u01/app/oraInventory. Adding read,write permissions for group. Removing read,write,execute permissions for world. Changing groupname of /u01/app/oraInventory to oinstall. The execution of the script is complete.

패치가 정상적으로 되었으면 첫번째 구성 스크립트를 실행햡니다.

클러스터를 구성할 모든 노드에 빠찜없이 수행합니다.

/u01/app/11g/grid/root.sh

[root@rac1 ~]# /u01/app/11g/grid/root.sh

Performing root user operation for Oracle 11g

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/11g/grid

Enter the full pathname of the local bin directory: [/usr/local/bin]:

Copying dbhome to /usr/local/bin ...

Copying oraenv to /usr/local/bin ...

Copying coraenv to /usr/local/bin ...

Creating /etc/oratab file...

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

Using configuration parameter file: /u01/app/11g/grid/crs/install/crsconfig_params

Creating trace directory

User ignored Prerequisites during installation

Installing Trace File Analyzer

OLR initialization - successful

root wallet

root wallet cert

root cert export

peer wallet

profile reader wallet

pa wallet

peer wallet keys

pa wallet keys

peer cert request

pa cert request

peer cert

pa cert

peer root cert TP

profile reader root cert TP

pa root cert TP

peer pa cert TP

pa peer cert TP

profile reader pa cert TP

profile reader peer cert TP

peer user cert

pa user cert

Adding Clusterware entries to oracle-ohasd.service

CRS-2672: Attempting to start 'ora.mdnsd' on 'rac1'

CRS-2676: Start of 'ora.mdnsd' on 'rac1' succeeded

CRS-2672: Attempting to start 'ora.gpnpd' on 'rac1'

CRS-2676: Start of 'ora.gpnpd' on 'rac1' succeeded

CRS-2672: Attempting to start 'ora.cssdmonitor' on 'rac1'

CRS-2672: Attempting to start 'ora.gipcd' on 'rac1'

CRS-2676: Start of 'ora.cssdmonitor' on 'rac1' succeeded

CRS-2676: Start of 'ora.gipcd' on 'rac1' succeeded

CRS-2672: Attempting to start 'ora.cssd' on 'rac1'

CRS-2672: Attempting to start 'ora.diskmon' on 'rac1'

CRS-2676: Start of 'ora.diskmon' on 'rac1' succeeded

CRS-2676: Start of 'ora.cssd' on 'rac1' succeeded

ASM이 성공적으로 생성되고 시작되었습니다.

디스크 그룹 CRS이(가) 성공적으로 생성되었습니다.

clscfg: -install mode specified

Successfully accumulated necessary OCR keys.

Creating OCR keys for user 'root', privgrp 'root'..

Operation successful.

CRS-4256: Updating the profile

Successful addition of voting disk 3d565099b3bd4f12bfd953417f1d8120.

Successful addition of voting disk 2f539dd6cd254ffabf7378fadde45b24.

Successful addition of voting disk 56d9ca743a024f5fbf23d5ba055ee1c5.

Successfully replaced voting disk group with +CRS.

CRS-4256: Updating the profile

CRS-4266: Voting file(s) successfully replaced

## STATE File Universal Id File Name Disk group

-- ----- ----------------- --------- ---------

1. ONLINE 3d565099b3bd4f12bfd953417f1d8120 (ORCL:CRS1) [CRS]

2. ONLINE 2f539dd6cd254ffabf7378fadde45b24 (ORCL:CRS2) [CRS]

3. ONLINE 56d9ca743a024f5fbf23d5ba055ee1c5 (ORCL:CRS3) [CRS]

Located 3 voting disk(s).

CRS-2672: Attempting to start 'ora.asm' on 'rac1'

CRS-2676: Start of 'ora.asm' on 'rac1' succeeded

CRS-2672: Attempting to start 'ora.CRS.dg' on 'rac1'

CRS-2676: Start of 'ora.CRS.dg' on 'rac1' succeeded

Configure Oracle Grid Infrastructure for a Cluster ... succeeded

[root@rac2 ~]# /u01/app/11g/grid/root.sh

Performing root user operation for Oracle 11g

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/11g/grid

Enter the full pathname of the local bin directory: [/usr/local/bin]:

Copying dbhome to /usr/local/bin ...

Copying oraenv to /usr/local/bin ...

Copying coraenv to /usr/local/bin ...

Creating /etc/oratab file...

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

Using configuration parameter file: /u01/app/11g/grid/crs/install/crsconfig_params

Creating trace directory

User ignored Prerequisites during installation

Installing Trace File Analyzer

OLR initialization - successful

Adding Clusterware entries to oracle-ohasd.service

CRS-4402: The CSS daemon was started in exclusive mode but found an active CSS daemon on node rac1, number 1, and is terminating

An active cluster was found during exclusive startup, restarting to join the cluster

Configure Oracle Grid Infrastructure for a Cluster ... succeeded

첫번째 구성 스크립트를 모든 노드에서 수행한 후, 두번째 구성 스크립트도 모든 노드에서 수행합니다.

반드시 한 노드에서 작업이 끝난 후에 다음 노드에서 작업을 진행해야 하며, 절대로 동시에 여러 노드에서 수행하면 안됩니다.

스크립트 실행을 모두 완료하였으면 OUI 화면으로 돌아와서 구성 스크립트 실행 창의 <OK> 버튼을 클릭합니다.

클러스터용 Oracle Grid Infrastructure 구성 작업이 진행됩니다.

Grid 설치가 모두 성공했습니다.

<Close> 버튼을 클릭해서 종료합니다

crsctl stat res -t

[root@rac1 ~]# crsctl stat res -t

--------------------------------------------------------------------------------

NAME TARGET STATE SERVER STATE_DETAILS

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.CRS.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.LISTENER.lsnr

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.asm

ONLINE ONLINE rac1 Started

ONLINE ONLINE rac2 Started

ora.gsd

OFFLINE OFFLINE rac1

OFFLINE OFFLINE rac2

ora.net1.network

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.ons

ONLINE ONLINE rac1

ONLINE ONLINE rac2

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE rac2

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE rac1

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE rac1

ora.cvu

1 ONLINE ONLINE rac1

ora.oc4j

1 ONLINE ONLINE rac1

ora.rac1.vip

1 ONLINE ONLINE rac1

ora.rac2.vip

1 ONLINE ONLINE rac2

ora.scan1.vip

1 ONLINE ONLINE rac2

ora.scan2.vip

1 ONLINE ONLINE rac1

ora.scan3.vip

1 ONLINE ONLINE rac1

{}

2. ASM 디스크 그룹 추가

grid_env export LANG=C asmca

ASM 디스크 그룹을 추가하기 위해 oracle 유저에서 asmca를 실행합니다

Linux 7 환경에서 11g OUI 수행시 한글이 깨지므로 LANG=C 옵션으로 언어 설정을 초기화 합니다.

Disk Groups 탭에서 <Create> 버튼을 클릭합니다.

Disk Group Name에 “DATA”를 입력하고 Redundancy는 ‘External(None)’을 선택합니다.

‘ORCL:DATA’를 체크한 후에 <OK>를 클릭합니다.

DATA 디스크 그룹이 성공적으로 생성된 메시지가 나옵니다.

<OK>를 클릭합니다.

FRA 디스크 그룹을 만들기 위해 다시 <Create>를 클릭합니다.

Disk Group Name에 “FRA”를 입력하고 Redundancy는 ‘External(None)’을 선택합니다.

‘ORCL:FRA’를 체크한 후에 <OK>를 클릭합니다.

FRA 디스크 그룹이 성공적으로 생성된 메시지가 나옵니다.

<OK>를 클릭합니다.

구성이 완료되었으므로 <Exit>을 클릭합니다.

프로그램 종료를 확인 메시지가 나오면 <Yes>를 클릭합니다.

crsctl stat res -t

[root@rac1 ~]# crsctl stat res -t

--------------------------------------------------------------------------------

NAME TARGET STATE SERVER STATE_DETAILS

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.CRS.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.DATA.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.FRA.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.LISTENER.lsnr

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.asm

ONLINE ONLINE rac1 Started

ONLINE ONLINE rac2 Started

ora.gsd

OFFLINE OFFLINE rac1

OFFLINE OFFLINE rac2

ora.net1.network

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.ons

ONLINE ONLINE rac1

ONLINE ONLINE rac2

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE rac2

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE rac1

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE rac1

ora.cvu

1 ONLINE ONLINE rac1

ora.oc4j

1 ONLINE ONLINE rac1

ora.rac1.vip

1 ONLINE ONLINE rac1

ora.rac2.vip

1 ONLINE ONLINE rac2

ora.scan1.vip

1 ONLINE ONLINE rac2

ora.scan2.vip

1 ONLINE ONLINE rac1

ora.scan3.vip

1 ONLINE ONLINE rac1

{}

VII. 11g Database 설치

1. Database 소프트웨어 설치

A) 환경 설정 및 OUI 실행

#db_env export LANG=C cd <Database 설치 파일 압축 디렉토리> ./runInstaller

Linux 7 에서는 11g의 OUI에서 한글이 표기가 되지 않으므로 LANG=C 설정으로 언어 표기를 초기화한 후 OUI를 실행합니다.

‘I wish to receive seurity updates via My Oracle Support’를 해제하고 <Next>를 클릭합니다.

전제 메일 주소 제공 관련 안내 메시지가 나오면 <Yes>를 클릭하여 설치를 계속 진행합니다.

‘Skip software updates’를 선택하고 <Next>를 클릭합니다.

‘Install database software only’를 선택하고 <Next>를 클릭합니다.

Oracle Real Application Clusters database installation’을 선택하고 <Select All>을 클릭하여 모든 노드를 체크합니다.

그리고 <Next>를 클릭합니다.

제품 언어에 ‘Korean’을 추가하고 <Next>를 클릭합니다

‘Enterprise Edition’을 선택하고 <Next>를 클릭합니다.

Oracle Base에 “/u01/app/oracle”을 입력하고 Software Location에 “/u01/app/oracle/product/11g/db_1”을 입력하고 <Next>를 클릭합니다.

데이터베이스 관리자 그룹에 ‘dba’, 운영자 그룹에 ‘oper’을 선택하고 <Next>를 클릭합니다.

데이터베이스 소프트웨어 설치에 필요한 조건을 검사합니다.

pdksh 패키지는 리눅스 7에서는 더이상 제공되지 않으며, 오라클(문서 1962046.1)로부터 무시해도 되는 패키지임을 확인 받았으므로 'Ignore All'을 체크하고 <Next>를 클릭합니다.

해당 패키지를 무시하는 것과 관련하여 안내 창이 뜨면 <Yes>를 클릭합니다.

설치에 대한 요약된 정보를 확인하고 이상이 없을 경우 <Install>을 클릭합니다.

데이터베이스 소프트웨어의 설치가 진행됩니다.

설치 진행 중 ins_emagent.mk 파일 관련 오류가 발생합니다.

오라클의 가이드(2299494.1)에 따라 해당 파일을 수정해야 정상적으로 설치를 진행할 수 있습니다.

B) ins_emagent.mk 파일 수정

#$(MK_EMAGENT_NMECTL) $(MK_EMAGENT_NMECTL) -lnnz11

vi 편집기로 해당 파일을 열어서 "$(MK_EMAGENT_NMECTL)"로 입력되어 있는 176번 줄의 내용을 "$(MK_EMAGENT_NMECTL) -lnnz11"로 수정한 후 저장합니다.

그리고 OUI 화면으로 돌아와서 <Retry> 버튼을 클릭합니다.

남은 설치가 진행됩니다.

마지막으로 구성 스크립트 실행 안내창이 뜹니다.

C) root 스크립트 실행

/u01/app/oracle/product/11g/db_1/root.sh

[root@rac1 ~]# /u01/app/oracle/product/11g/db_1/root.sh

Performing root user operation for Oracle 11g

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/oracle/product/11g/db_1

Enter the full pathname of the local bin directory: [/usr/local/bin]:

The contents of "dbhome" have not changed. No need to overwrite.

The contents of "oraenv" have not changed. No need to overwrite.

The contents of "coraenv" have not changed. No need to overwrite.

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

Finished product-specific root actions.

[root@rac2 ~]# /u01/app/oracle/product/11g/db_1/root.sh

Performing root user operation for Oracle 11g

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/oracle/product/11g/db_1

Enter the full pathname of the local bin directory: [/usr/local/bin]:

The contents of "dbhome" have not changed. No need to overwrite.

The contents of "oraenv" have not changed. No need to overwrite.

The contents of "coraenv" have not changed. No need to overwrite.

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

Finished product-specific root actions.

루트 사용자 권한으로 모든 노드에서 스크립트를 실행합니다.

스크립트를 모두 실행한 후에 OUI 화면으로 돌아와서 <OK>를 클릭하면 설치 성공 메시지가 출력됩니다.

<Close>를 클릭하여 설치를 완료합니다.

{}

2. Database 생성

# db_env export LANG=C dbca

Linux 7 에서는 11g의 OUI에서 한글이 표기가 되지 않으므로 LANG=C 설정으로 언어 표기를 초기화한 후 DBCA를 실행합니다.

‘Oracle Real Application Clusters(RAC) database’를 선택하고 <Next>를 클릭합니다.

‘Create Database’를 선택하고 <Next>를 클릭합니다.

‘General Purpose or Transaction Processing’을 선택하고 <Next>를 클릭합니다

‘Admin-Managed’가 체크된 상태에서 Global Database Name에 “racdb”을 입력하고 SID Prefix에 “racdb”를 입력합니다.

모든 노드에 설치하기 위해 <Select All>을 클릭하고 <Next>를 클릭합니다.

리소스 절약을 위해 'Configure Enterprise Manager '의 체크를 해제하고 <Next>를 클릭합니다.

‘Use the Same Administrative Password for All Accounts’를 체크하고 Password로 ‘oracle_4U’를 입력한 후 <Next>를 클릭합니다.

ASM에 데이터베이스를 구성할 것이므로 Storage Type이 'Automatic Storage Management(ASM)'으로 되어 있는지 확인합니다.

'Use Oracle-Managed Files'가 선택되어 있고, Database Area에 "+DATA" 디스크 그룹으로 되어 있는지 확인합니다.

<Multiplex Redo Logs and Control Files>를 클릭합니다.

Redo Logs와 Control Files를 여러 곳에 저장할 수 있도록 "+DATA"와 "+FRA"를 입력한 후 <OK>를 클릭합니다.

<Next>를 클릭합니다.

Fast Recovery Area를 FRA 디스크 그룹으로 변경하기 위해 <Browse>를 클릭합니다.

‘FRA’를 선택하고 <OK>를 클릭합니다.

아카이브 설정을 데이터베이스 생성을 완료하거나 업그레이드 한 후에 활성화하는 것이 좋으므로, 우선은 <Next>를 클릭합니다.

샘플 스키마 설치 여부를 선택할 수 있습니다.

수정할 내용이 없으면 <Next>를 클릭합니다.

할당된 메모리 내역을 확인할 수 있으며, 자동 메모리 관리 사용 여부도 선택할 수 있습니다.

<All Initialization Parameters> 버튼을 클릭하면, 인스턴스 파라미터를 수정할 수 있습니다.

프로세스의 수도 사용할 환경에 맞게 변경할 수 있습니다.

‘Choose from the list of charactersets’을 선택하고, Database Character Set은 'KO16MSWIN949'를 선택합니다.

Default Language는 'American'으로 하고 Default Territory는 'Korea'로 합니다.

운영환경에서 문자와 언어를 선택하는 과정은 매우 중요합니다.

어플리케이션과의 호환성을 고려하여 신중하게 선택해야 합니다.

접속 모드는 기본값인 ‘Dedicated Server Mode’로 두고 <Next>를 클릭합니다.

데이터베이스 저장 영역에 대한 정보를 확인할 수 있습니다.

기본적으로 Redo Log는 4개의 그룹에 50MB 용량으로 구성됩니다.

2개의 인스턴스에서 2개의 그룹으로 50MB를 사용하게 되므로 빈번한 로그 스위차와 대기 이벤트가 발생하기 쉽습니다.

그룹 2개를 더 추가하여 인스턴스별로 3개의 그룹을 사용할 수 있도록 수정하고, 파일 크기는 200MB로 변경해주도록 합니다.

구성이 마무리되었으면 <Next>를 클릭합니다.

‘Create Database’을 체크하고 <Finish>를 클릭합니다.

데이터베이스 생성에 관한 요약 정보가 출력됩니다.

화면을 내려 구성에 대한 요약 정보를 검토할 수 있습니다.

변경할 내용이 없으면 <OK>를 클릭합니다.

데이터베이스 구성이 진행됩니다.

데이터베이스 구성이 완료되었음을 알리는 안내창이 뜹니다.

<Exit>을 클릭합니다.

crsctl stat res -t

[root@rac1 ~]# crsctl stat res -t

--------------------------------------------------------------------------------

NAME TARGET STATE SERVER STATE_DETAILS

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.CRS.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.DATA.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.FRA.dg

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.LISTENER.lsnr

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.asm

ONLINE ONLINE rac1 Started

ONLINE ONLINE rac2 Started

ora.gsd

OFFLINE OFFLINE rac1

OFFLINE OFFLINE rac2

ora.net1.network

ONLINE ONLINE rac1

ONLINE ONLINE rac2

ora.ons

ONLINE ONLINE rac1

ONLINE ONLINE rac2

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE rac2

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE rac1

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE rac1

ora.cvu

1 ONLINE ONLINE rac1

ora.oc4j

1 ONLINE ONLINE rac1

ora.rac1.vip

1 ONLINE ONLINE rac1

ora.rac2.vip

1 ONLINE ONLINE rac2

ora.racdb.db

1 ONLINE ONLINE rac1 Open

2 ONLINE ONLINE rac2 Open

ora.scan1.vip

1 ONLINE ONLINE rac2

ora.scan2.vip

1 ONLINE ONLINE rac1

ora.scan3.vip

1 ONLINE ONLINE rac1

{}

VIII. 업그레이드 사전 준비

1. ASM 호환성 업그레이드

grid_env export LANG=C asmca

Linux 7 에서는 11g의 OUI에서 한글이 표기가 되지 않으므로 LANG=C 설정으로 언어 표기를 초기화한 후 ASMCA를 실행합니다.

11.2에서 구성된 ASM을 19c에서 사용하려면 ASM 호환성을 최소 11.2.0.2 이상으로 지정해야 합니다.

맨먼저 CRS 디스크 그룹의 호환성을 변경하기 위해 디스크 그룹 목록에서 CRS를 마우스 우측 버튼으로 클릭합니다.

드롭다운 메뉴가 펼쳐지면 'Edit Attributes'를 클릭합니다.

ASM Compatibility를 "11.2.0.2.0"으로 수정하고, <OK>를 클릭합니다.

FRA 디스크 그룹의 호환성을 변경하기 위해 디스크 그룹 목록에서 FRA를 마우스 우측 버튼으로 클릭합니다.

드롭다운 메뉴가 펼쳐지면 'Edit Attributes'를 클릭합니다.

ASM Compatibility를 "11.2.0.2.0"으로 수정하고, <OK>를 클릭합니다.

마지막으로 DATA 디스크 그룹의 호환성을 변경하기 위해 디스크 그룹 목록에서 DATA를 마우스 우측 버튼으로 클릭합니다.

드롭다운 메뉴가 펼쳐지면 'Edit Attributes'를 클릭합니다.

ASM Compatibility를 "11.2.0.2.0"으로 수정하고, <OK>를 클릭합니다.

모든 디스크 그룹의 ASM 호환성을 업그레이드했다면 <Exit>을 클릭하여 ASMCA를 종료합니다.

종료에 대한 확인 창이 뜨면 <Yes>를 클릭합니다.

{}

2. 11g PSU 패치 적용

A) OPatch 업데이트

$DB_HOME/OPatch/opatch version mv $DB_HOME/OPatch $DB_HOME/OPatch.bak cp -r $GRID_HOME/OPatch $DB_HOME chown -R oracle:oinstall $DB_HOME/OPatch $DB_HOME/OPatch/opatch version

[root@rac1 ~]# $GRID_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.23 OPatch succeeded. [root@rac1 ~]# $DB_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.4 OPatch succeeded. [root@rac1 ~]# mv $DB_HOME/OPatch $DB_HOME/OPatch.bak [root@rac1 ~]# cp -r $GRID_HOME/OPatch $DB_HOME [root@rac1 ~]# chown -R oracle:oinstall $DB_HOME/OPatch [root@rac1 ~]# $DB_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.23 OPatch succeeded.

[root@rac2 ~]# $GRID_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.23 OPatch succeeded. [root@rac2 ~]# $DB_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.4 OPatch succeeded. [root@rac2 ~]# mv $DB_HOME/OPatch $DB_HOME/OPatch.bak [root@rac2 ~]# cp -r $GRID_HOME/OPatch $DB_HOME [root@rac2 ~]# chown -R oracle:oinstall $DB_HOME/OPatch [root@rac2 ~]# $DB_HOME/OPatch/opatch version OPatch Version: 11.2.0.3.23 OPatch succeeded.

B) 사전 조사

grid_env opatch lspatches db_env opatch lspatches

[racdb1:/home/oracle]> grid_env [+ASM1:/home/oracle]> opatch lspatches 18370031;Grid Infrastructure Patch Set Update : 11.2.0.4.x (gibugno) OPatch succeeded. [+ASM1:/home/oracle]> db_env [racdb1:/home/oracle]> opatch lspatches 이 Oracle 홈에 설치된 Interim 패치가 없습니다 "/u01/app/oracle/product/11g/db_1". OPatch succeeded.

[racdb2:/home/oracle]> grid_env [+ASM2:/home/oracle]> opatch lspatches 18370031;Grid Infrastructure Patch Set Update : 11.2.0.4.x (gibugno) OPatch succeeded. [+ASM2:/home/oracle]> db_env [racdb2:/home/oracle]> opatch lspatches 이 Oracle 홈에 설치된 Interim 패치가 없습니다 "/u01/app/oracle/product/11g/db_1". OPatch succeeded.

{}

$GRID_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -ph <패치 압축 해제 디렉토리>/30501155 -oh $GRID_HOME $DB_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -ph <패치 압축 해제 디렉토리>/30501155 -oh $DB_HOME

[racdb1:/home/oracle]> $GRID_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -ph /media/sf_oracle/11.2/30501155 -oh $GRID_HOME Oracle Interim 패치 설치 프로그램 버전 11.2.0.3.23 Copyright (c) 2020, Oracle Corporation. All rights reserved. PREREQ session Oracle 홈: /u01/app/11g/grid 중앙 인벤토리: /u01/app/oraInventory 출처: /u01/app/11g/grid/oraInst.loc OPatch 버전: 11.2.0.3.23 OUI 버전: 11.2.0.4.0 로그 파일 위치: /u01/app/11g/grid/cfgtoollogs/opatch/opatch2020-03-28_22-58-11오후_1.log Invoking prereq "checkconflictagainstohwithdetail" Prereq "checkConflictAgainstOHWithDetail" passed. OPatch succeeded. [racdb1:/home/oracle]> $DB_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -ph /media/sf_oracle/11.2/30501155 -oh $DB_HOME Oracle Interim 패치 설치 프로그램 버전 11.2.0.3.23 Copyright (c) 2020, Oracle Corporation. All rights reserved. PREREQ session Oracle 홈: /u01/app/oracle/product/11g/db_1 중앙 인벤토리: /u01/app/oraInventory 출처: /u01/app/oracle/product/11g/db_1/oraInst.loc OPatch 버전: 11.2.0.3.23 OUI 버전: 11.2.0.4.0 로그 파일 위치: /u01/app/oracle/product/11g/db_1/cfgtoollogs/opatch/opatch2020-03-28_22-58-25오후_1.log Invoking prereq "checkconflictagainstohwithdetail" Prereq "checkConflictAgainstOHWithDetail" passed. OPatch succeeded.

[racdb1:/home/oracle]> $GRID_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -ph /media/sf_oracle/11.2/30501155 -oh $GRID_HOME Oracle Interim 패치 설치 프로그램 버전 11.2.0.3.23 Copyright (c) 2020, Oracle Corporation. All rights reserved. PREREQ session Oracle 홈: /u01/app/11g/grid 중앙 인벤토리: /u01/app/oraInventory 출처: /u01/app/11g/grid/oraInst.loc OPatch 버전: 11.2.0.3.23 OUI 버전: 11.2.0.4.0 로그 파일 위치: /u01/app/11g/grid/cfgtoollogs/opatch/opatch2020-03-28_22-58-11오후_1.log Invoking prereq "checkconflictagainstohwithdetail" Prereq "checkConflictAgainstOHWithDetail" passed. OPatch succeeded. [racdb1:/home/oracle]> $DB_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -ph /media/sf_oracle/11.2/30501155 -oh $DB_HOME Oracle Interim 패치 설치 프로그램 버전 11.2.0.3.23 Copyright (c) 2020, Oracle Corporation. All rights reserved. PREREQ session Oracle 홈: /u01/app/oracle/product/11g/db_1 중앙 인벤토리: /u01/app/oraInventory 출처: /u01/app/oracle/product/11g/db_1/oraInst.loc OPatch 버전: 11.2.0.3.23 OUI 버전: 11.2.0.4.0 로그 파일 위치: /u01/app/oracle/product/11g/db_1/cfgtoollogs/opatch/opatch2020-03-28_22-58-25오후_1.log Invoking prereq "checkconflictagainstohwithdetail" Prereq "checkConflictAgainstOHWithDetail" passed. OPatch succeeded.

C) 1번 노드 패치

$DB_HOME/OPatch/opatch auto <패치 압축 해제 디렉토리>/30501155 -oh $DB_HOME

[root@rac1 ~]# $DB_HOME/OPatch/opatch auto /media/sf_oracle/11.2/30501155 -oh $DB_HOME Executing /u01/app/11g/grid/perl/bin/perl /u01/app/oracle/product/11g/db_1/OPatch/crs/patch11203.pl -patchdir /media/sf_oracle/11.2 -patchn 30501155 -oh /u01/app/oracle/product/11g/db_1 -paramfile /u01/app/11g/grid/crs/install/crsconfig_params This is the main log file: /u01/app/oracle/product/11g/db_1/cfgtoollogs/opatchauto2020-03-28_23-00-33.log This file will show your detected configuration and all the steps that opatchauto attempted to do on your system: /u01/app/oracle/product/11g/db_1/cfgtoollogs/opatchauto2020-03-28_23-00-33.report.log 2020-03-28 23:00:33: Starting Clusterware Patch Setup Using configuration parameter file: /u01/app/11g/grid/crs/install/crsconfig_params Stopping RAC /u01/app/oracle/product/11g/db_1 ... Stopped RAC /u01/app/oracle/product/11g/db_1 successfully patch /media/sf_oracle/11.2/30501155/29938455/custom/server/29938455 apply successful for home /u01/app/oracle/product/11g/db_1 patch /media/sf_oracle/11.2/30501155/30298532 apply successful for home /u01/app/oracle/product/11g/db_1 Starting RAC /u01/app/oracle/product/11g/db_1 ... Started RAC /u01/app/oracle/product/11g/db_1 successfully opatch auto succeeded.

$GRID_HOME/OPatch/opatch auto <패치 압축 해제 디렉토리>/30501155 -oh $GRID_HOME

[root@rac1 ~]# $GRID_HOME/OPatch/opatch auto /media/sf_oracle/11.2/30501155 -oh $GRID_HOME Executing /u01/app/11g/grid/perl/bin/perl /u01/app/11g/grid/OPatch/crs/patch11203.pl -patchdir /media/sf_oracle/11.2 -patchn 30501155 -oh /u01/app/11g/grid -paramfile /u01/app/11g/grid/crs/install/crsconfig_params This is the main log file: /u01/app/11g/grid/cfgtoollogs/opatchauto2020-03-28_23-07-30.log This file will show your detected configuration and all the steps that opatchauto attempted to do on your system: /u01/app/11g/grid/cfgtoollogs/opatchauto2020-03-28_23-07-30.report.log 2020-03-28 23:07:30: Starting Clusterware Patch Setup Using configuration parameter file: /u01/app/11g/grid/crs/install/crsconfig_params Stopping CRS... Stopped CRS successfully patch /media/sf_oracle/11.2/30501155/29938455 apply successful for home /u01/app/11g/grid patch /media/sf_oracle/11.2/30501155/30298532 apply successful for home /u01/app/11g/grid patch /media/sf_oracle/11.2/30501155/29509309 apply successful for home /u01/app/11g/grid Starting CRS... Installing Trace File Analyzer CRS-4123: Oracle High Availability Services has been started. opatch auto succeeded.

grid_env opatch lspatches db_env opatch lspatches

[racdb1:/home/oracle]> grid_env [+ASM1:/home/oracle]> opatch lspatches 30298532;Database Patch Set Update : 11.2.0.4.200114 (30298532) 29509309;ACFS Patch Set Update : 11.2.0.4.190716 (29509309) 29938455;OCW Patch Set Update : 11.2.0.4.191015 (29938455) OPatch succeeded. [+ASM1:/home/oracle]> db_env [racdb1:/home/oracle]> opatch lspatches 30298532;Database Patch Set Update : 11.2.0.4.200114 (30298532) 29938455;OCW Patch Set Update : 11.2.0.4.191015 (29938455) OPatch succeeded.

D) 2번 노드 패치

$DB_HOME/OPatch/opatch auto <패치 압축 해제 디렉토리>/30501155 -oh $DB_HOME

[root@rac2 ~]# $DB_HOME/OPatch/opatch auto /media/sf_oracle/11.2/30501155 -oh $DB_HOME Executing /u01/app/11g/grid/perl/bin/perl /u01/app/oracle/product/11g/db_1/OPatch/crs/patch11203.pl -patchdir /media/sf_oracle/11.2 -patchn 30501155 -oh /u01/app/oracle/product/11g/db_1 -paramfile /u01/app/11g/grid/crs/install/crsconfig_params This is the main log file: /u01/app/oracle/product/11g/db_1/cfgtoollogs/opatchauto2020-03-28_23-20-14.log This file will show your detected configuration and all the steps that opatchauto attempted to do on your system: /u01/app/oracle/product/11g/db_1/cfgtoollogs/opatchauto2020-03-28_23-20-14.report.log 2020-03-28 23:20:14: Starting Clusterware Patch Setup Using configuration parameter file: /u01/app/11g/grid/crs/install/crsconfig_params Stopping RAC /u01/app/oracle/product/11g/db_1 ... Stopped RAC /u01/app/oracle/product/11g/db_1 successfully patch /media/sf_oracle/11.2/30501155/29938455/custom/server/29938455 apply successful for home /u01/app/oracle/product/11g/db_1 patch /media/sf_oracle/11.2/30501155/30298532 apply successful for home /u01/app/oracle/product/11g/db_1 Starting RAC /u01/app/oracle/product/11g/db_1 ... Started RAC /u01/app/oracle/product/11g/db_1 successfully opatch auto succeeded.

$GRID_HOME/OPatch/opatch auto <패치 압축 해제 디렉토리>/30501155 -oh $GRID_HOME